Zusammenfassung:

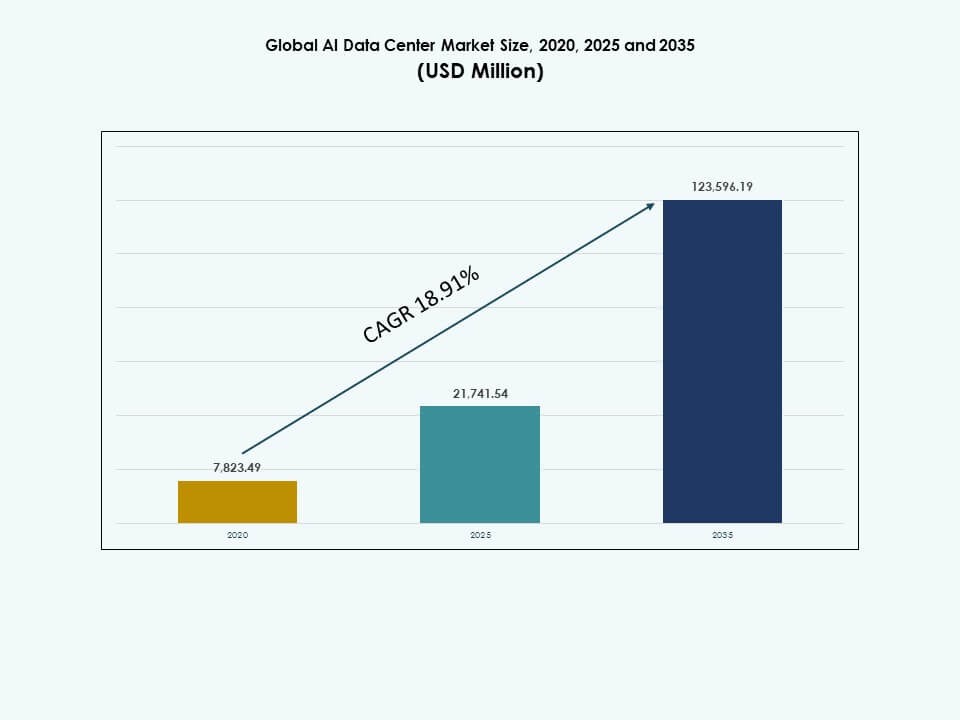

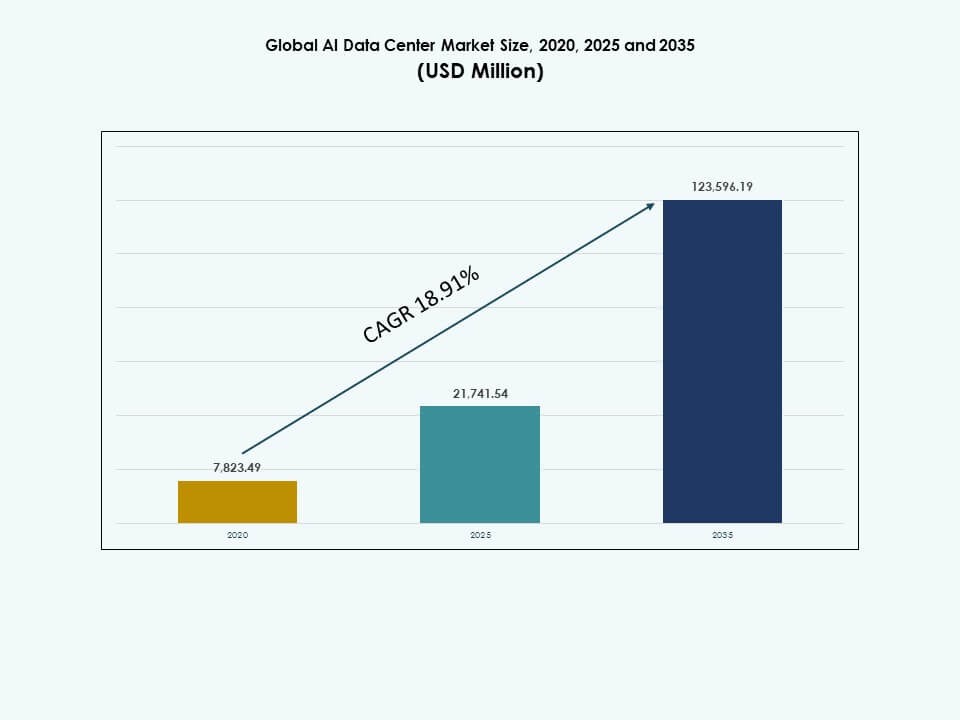

Die Größe des globalen AI-Datenzentrenmarktes wurde im Jahr 2020 auf 7.823,49 Millionen USD geschätzt, stieg bis 2025 auf 21.741,54 Millionen USD und wird voraussichtlich bis 2035 123.596,19 Millionen USD erreichen, mit einer durchschnittlichen jährlichen Wachstumsrate (CAGR) von 18,91 % während des Prognosezeitraums.

| BERICHTSATTRIBUT |

DETAILS |

| Historischer Zeitraum |

2020-2023 |

| Basisjahr |

2024 |

| Prognosezeitraum |

2025-2035 |

| Größe des AI-Datenzentrenmarktes 2025 |

21.741,54 Millionen USD |

| AI-Datenzentrenmarkt, CAGR |

18,91% |

| Größe des AI-Datenzentrenmarktes 2035 |

123.596,19 Millionen USD |

Der globale AI-Datenzentrenmarkt expandiert aufgrund der schnellen Einführung von generativer KI, maschinellem Lernen und fortschrittlicher Analytik in verschiedenen Branchen. Unternehmen setzen Hochleistungsrechner ein, um komplexe KI-Modelle und Echtzeit-Datenverarbeitung zu unterstützen. Innovationen in GPUs, kundenspezifischen Beschleunigern und Kühlsystemen verbessern Effizienz und Skalierbarkeit. Cloud-Plattformen ermöglichen flexible KI-Bereitstellungen. Diese Veränderungen machen AI-Datenzentren zu kritischen Vermögenswerten für digitale Transformation, Produktivitätssteigerungen und langfristigen Investorenwert.

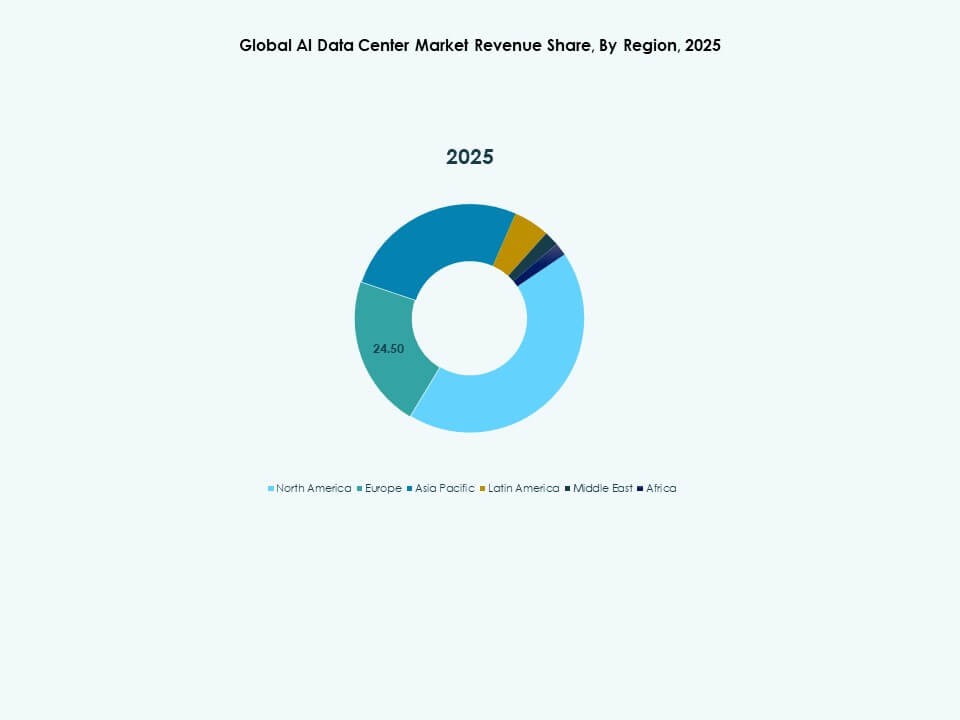

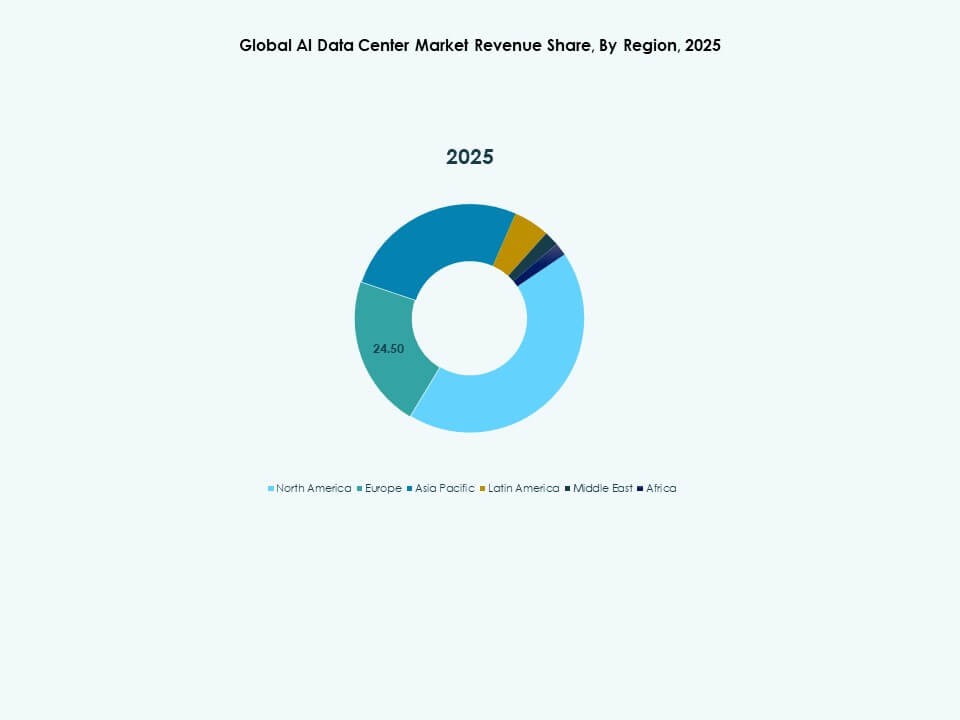

Der globale AI-Datenzentrenmarkt zeigt eine starke regionale Konzentration in Nordamerika, angeführt von den Vereinigten Staaten aufgrund der Präsenz von Hyperscalern und der frühen Einführung von KI. Der asiatisch-pazifische Raum entwickelt sich schnell, angetrieben von China, Japan, Südkorea und Indien, die in KI-Infrastruktur und Datenlokalisierung investieren. Europa folgt mit einem Fokus auf nachhaltige und konforme KI-Einrichtungen. Aufstrebende Regionen gewinnen durch Cloud-Expansion und Initiativen zur digitalen Wirtschaft an Bedeutung.

Markttreiber

Markttreiber

Einführung von KI-optimierter Hardware und beschleunigter Computerinfrastruktur

Der globale AI-Datenzentrenmarkt gewinnt durch die starke Nachfrage nach GPU- und ASIC-basierten Systemen an Dynamik. Hochleistungsprozessoren ermöglichen KI-Training und -Inferenzen mit geringer Latenz. Unternehmen ersetzen veraltete CPU-Infrastrukturen, um Deep-Learning-Aufgaben effizient zu skalieren. Beschleuniger von NVIDIA, AMD und Intel gestalten die Computerarchitektur über KI-gesteuerte Workloads neu. Hyperscaler investieren in proprietäre Chipsets, um den Stromverbrauch zu senken und den Durchsatz zu erhöhen. Diese Trends verbessern die Betriebsgeschwindigkeit und unterstützen große Datenmengen. Der Wechsel zu speziell entwickelter Hardware ermöglicht eine bessere Leistung von KI-Modellen. Branchen wie Gesundheitswesen, Finanzen und Fertigung verlassen sich auf KI-Computing für Echtzeitentscheidungen. Diese Entwicklung treibt langfristige Investitionen in intelligente Datenzentren voran.

- Zum Beispiel unterstützt NVIDIAs A100 GPU die Aufteilung in mehrere Instanzen (MIG) in bis zu sieben isolierte Instanzen und liefert eine Deep-Learning-Durchsatzrate, die in Benchmarks wie dem Training von Sprachmodellen mit FP16-Tensor-Kernen bis zu 2,5-mal höher ist als die der V100.

Erweiterung von Edge-KI und verteilten Datenarchitekturen

Die Integration von Edge AI treibt den globalen AI-Datenzentrum-Markt in Richtung dezentraler Verarbeitung. Unternehmen setzen AI-Modelle näher an den Datenquellen ein, um Latenz und Bandbreitenkosten zu reduzieren. Echtzeitanalysen am Edge unterstützen autonome Systeme, IoT und industrielle AI-Anwendungsfälle. Datenzentren passen sich an, indem sie regionale und Mikro-Einrichtungen in der Nähe wichtiger Endpunkte errichten. Telekommunikationsunternehmen und Hyperscaler arbeiten zusammen, um verteilte AI-bereite Zonen zu schaffen. Diese Infrastrukturen optimieren den Datenfluss, insbesondere in stark frequentierten Umgebungen. Regulatorische Veränderungen in Bezug auf Datensouveränität unterstützen das Wachstum regionaler Infrastrukturen. Unternehmen mit globaler Präsenz verlangen nach widerstandsfähiger und latenzsensitiver AI-Verarbeitung. Dies schafft Wert in Sektoren wie Smart Cities, Verteidigung und Automobilindustrie.

Cloud-native AI-Plattformen und Modelllebenszyklus-Management

Cloud-native AI-Dienste transformieren, wie Unternehmen Modelllebenszyklen skalieren und verwalten. Der globale AI-Datenzentrum-Markt profitiert von der Nachfrage nach MLOps, AI-Orchestrierung und containerisierten Workloads. Anbieter konzentrieren sich darauf, die Infrastruktur für dynamische Modellversionierung, Training und Bereitstellung zu optimieren. Dieser Wandel unterstützt agile Entwicklung und Echtzeit-Neu-Training für verbesserte Genauigkeit. Multi-Cloud- und hybride Umgebungen verbessern die Kontinuität von AI-Diensten. Organisationen verlassen sich auf cloud-integrierte Pipelines, um die Datenaufnahme, -kennzeichnung und -inferenz zu automatisieren. Diese Operationen erfordern flexible, skalierbare und sichere Rechenökosysteme. Strategische Cloud-Investitionen großer Anbieter prägen die Reife des AI-Ökosystems. AI-Lebenszyklus-Plattformen stärken die Wettbewerbspositionierung über alle Unternehmensebenen hinweg.

- Zum Beispiel bietet NVIDIAs H100 Tensor Core GPU eine 4-mal schnellere Schulung als die A100 bei großen Sprachmodellen in MLPerf-Benchmarks.

Regierungsgeführte AI-Infrastrukturfinanzierung und AI-Souveränität

Strategische Politik- und Finanzierungsprogramme treiben nationale AI-Infrastrukturpipelines an. Länder stellen Budgets bereit, um souveräne AI-Clouds, nationale Rechengewebe und spezialisierte Datenzentren aufzubauen. Der globale AI-Datenzentrum-Markt stimmt mit diesen Bemühungen überein, um Unabhängigkeit in der AI-Entwicklung zu erreichen. Regulierungsbehörden konzentrieren sich darauf, AI-kritische Infrastrukturen vor geopolitischen und Cybersicherheitsrisiken zu schützen. Regierungsinvestitionen erstrecken sich auf grünes Rechnen, Quanten-AI und Modelltraining im öffentlichen Sektor. Partnerschaften zwischen öffentlichen Agenturen und Technologieunternehmen treiben Skalierung und Lokalisierung voran. AI-Zentren, die sich auf Verteidigung, Sprachverarbeitung und wissenschaftliche Simulationen konzentrieren, haben höchste Priorität. Diese Initiativen verbessern die Zugänglichkeit und Leistung von AI-Diensten im großen Maßstab. Nationale AI-Ambitionen prägen das Design, den Standort und den Betrieb von Dateninfrastrukturen weltweit.

Markttrends

Markttrends

Die Expansion von generativen AI-Workloads treibt die Nachfrage nach Hochdurchsatz-Computing an

Der globale Markt für KI-Rechenzentren erlebt aufgrund der Einführung generativer KI einen schnellen Skalierungsbedarf. Große Sprachmodelle und Bildgeneratoren erfordern umfangreiche GPU-Cluster und massive Speicherbandbreite. Diese Workloads verbrauchen mehr Strom und Platz als herkömmliche Anwendungen. Anbieter investieren in rack-dichte Architekturen mit fortschrittlichen thermischen Lösungen. Der Einsatz von Flüssigkeits- und Immersionskühlsystemen wird weit verbreitet. Generative KI beeinflusst die Anlagenplanung mit speziell entwickelten Zonen für Training und Inferenz. Der Trend erhöht den Bedarf an dedizierter Stromverteilung und Hochgeschwindigkeitsnetzwerken. KI-Cluster dominieren nun die Planung neuer Kapazitäten und beeinflussen Immobilien- und Kapitalallokation. Betreiber suchen nach Innovationen, um energiehungrige, datenintensive Modelle unterzubringen.

Fokus auf nachhaltiges KI-Rechenzentrumsdesign und Energieoptimierung

Nachhaltigkeit treibt den architektonischen Wandel in der Planung von KI-Rechenzentren voran. Betreiber streben danach, die KI-Leistung mit einem reduzierten CO2-Fußabdruck in Einklang zu bringen. Der Einsatz modularer Designs, die Wiederverwendung von Abwärme und die Nutzung erneuerbarer Energien nehmen zu. Der globale Markt für KI-Rechenzentren steht unter Druck, trotz steigender Rechenlasten nahezu emissionsfrei zu werden. Hyperscaler integrieren softwaredefinierte Energiesysteme, um die Lastverteilung zu optimieren. Die Planung von KI-Workloads richtet sich nach der Verfügbarkeit erneuerbarer Energien. Zertifizierungen für umweltfreundliches Bauen werden bei Tier-III- und Tier-IV-Bauten zum Standard. Die Ziele für die Energieeffizienz (PUE) werden durch fortschrittliche Kühlung gesenkt. Nachhaltigkeitsverpflichtungen beeinflussen Investorenentscheidungen und behördliche Genehmigungen.

Anstieg von KI-spezifischen Colocation- und Hyperscale-Partnerschaften

Colocation-Anbieter entwickeln ihre Angebote weiter, um KI-Workloads mit maßgeschneiderter Infrastruktur zu unterstützen. Der globale Markt für KI-Rechenzentren profitiert von Einrichtungen, die höhere Leistungsdichte, schnelle Bereitstellung und flexible Skalierung bieten. Unternehmenskunden suchen nach fertigen Umgebungen für die Entwicklung und Bereitstellung von KI-Modellen. Hyperscaler und Chip-Hersteller bilden strategische Allianzen, um Flächen mit optimaler Kühlung und Vernetzung zu mieten. Multi-Tenant-KI-Zonen mit fortschrittlichen Verbindungen verkürzen die Zeit bis zur Modellbereitstellung. Betreiber rüsten bestehende Standorte mit hochdichten Racks nach, um die Nachfrage zu decken. Colocation expandiert von Tier-I-Städten zu regionalen Zentren. Diese Einrichtungen bieten langfristige Verträge mit KI-fähigen Funktionen und ziehen Deep-Tech-Startups und Forschungslabore an.

Integration von optischen Verbindungen und KI-optimierten Netzwerken

Netzwerkinnovationen stehen im Mittelpunkt der Entwicklung des globalen Marktes für KI-Rechenzentren. KI-Cluster erfordern latenzarme, hochdurchsatzfähige Verbindungen zwischen Knoten und Datenpools. Betreiber setzen Glasfaser, Silizium-Photonik und 800G-Ethernet ein, um Engpässe zu beseitigen. Intelligente Switches und programmierbare Router erhöhen die Effizienz von KI-Aufgaben. KI-gesteuertes Verkehrsmanagement verbessert die Ressourcenverteilung in Rechenzentren. Der Einsatz von KI zur Verwaltung von KI-Workloads—KI-für-KI—nimmt zu. Optische Backbone-Netze unterstützen die Modellparallelität und schnellere Datensynchronisation. Die Integration von Next-Gen-Netzwerken reduziert Infrastrukturverzögerungen und verbessert die Energienutzung. Diese Innovationen prägen das Layout, das Design und die Kostenmodelle von KI-zentrierten Standorten.

Marktherausforderungen

Marktherausforderungen

Hoher Energieverbrauch und begrenzte Netzkapazität in Schlüsselregionen

Der globale Markt für KI-Rechenzentren steht aufgrund des hohen Energiebedarfs für das KI-Training unter zunehmender Beobachtung. Dichte GPU-Cluster können über 30 kW pro Rack hinausgehen und die bestehende Strominfrastruktur belasten. Die Energieverbrauchsmuster übersteigen die herkömmlicher Cloud-Anwendungen. Die Verfügbarkeit von Strom in städtischen Zentren wird zu einem begrenzenden Faktor für neue Bauten. Lokale Netze in Europa, Teilen Asiens und dicht besiedelten Metropolen kämpfen mit der Lastverteilung. Der regulatorische Druck nimmt zu, da Regierungen die Kohlenstoffauswirkungen von KI-Berechnungen bewerten. Projektverzögerungen aufgrund von Netzbeschränkungen beeinträchtigen Skalierungspläne. Lange Vorlaufzeiten für elektrische Upgrades stören die Zeitpläne von Hyperscalern. Dies zwingt Betreiber, alternative Standorte in weniger überlasteten Zonen zu suchen.

Komplexität des Wärmemanagements und der Betriebssicherheit

KI-spezifische Rechenzentren stehen vor erheblichen Herausforderungen bei der Aufrechterhaltung der thermischen Stabilität. Traditionelle Luftkühlung versagt bei extremen GPU-Lasten. Betreiber müssen in fortschrittliche Kühlsysteme wie Direkt-zu-Chip- oder Immersionskühlung investieren. Diese Systeme erfordern Neugestaltungen in Layout, Rohrleitungen und Betriebsaufsicht. Der globale Markt für KI-Rechenzentren passt sich nur langsam an die schnellen Veränderungen in der Kühltechnologie an. Das Risiko eines thermischen Durchgehens, einer verkürzten Lebensdauer der Komponenten und Systemausfällen steigt. Kontinuierliche Überwachung und adaptive Steuerung werden entscheidend. Ingenieure stehen vor steigender betrieblicher Komplexität bei der Verwaltung hybrider Umgebungen. Zuverlässigkeitsstandards müssen sich weiterentwickeln, um eine ununterbrochene KI-Leistung in verschiedenen Regionen und Anwendungsfällen zu gewährleisten.

Marktchancen

Lokalisierung der KI-Infrastruktur und Potenzial für den Einsatz in aufstrebenden Märkten

Der globale Markt für KI-Rechenzentren bietet großes Potenzial in aufstrebenden Volkswirtschaften, die darauf abzielen, KI-Berechnungen zu lokalisieren. Länder in Südostasien, Afrika und Lateinamerika verfolgen eine souveräne KI-Infrastruktur, um lokale Modelle zu unterstützen und den Datenexport zu reduzieren. Regierungen und Privatsektoren stimmen sich auf den Aufbau lokalisierter Datenzentren ab, um KI-Innovation und digitale Fähigkeiten zu fördern. Diese Regionen bieten kostengünstiges Land, qualifizierte Arbeitskräfte und politische Anreize. Investoren finden Wachstum in Greenfield-Entwicklungen und regionalen Clustern, die die KI-Ambitionen der Regierung unterstützen.

Spezialisierung auf vertikalspezifische KI-Berechnungszonen

Betreiber können neuen Wert erschließen, indem sie KI-Berechnungen anbieten, die auf bestimmte Sektoren zugeschnitten sind. Rechenzentren, die für Finanzmodelle, Biotech-Simulationen oder autonome Systeme optimiert sind, ziehen Nischenbedarf an. Der globale Markt für KI-Rechenzentren profitiert von vertikalen KI-Zonen, die Sektorexpertise mit maßgeschneiderter Infrastruktur integrieren. Dieser Ansatz verkürzt die Zeit bis zum Wert für domänenspezifische KI-Entwicklung. Gesundheitswesen, Verteidigung, Logistik und Energiesektoren führen die Nachfrage nach diesen speziell entwickelten Umgebungen an.

Marktsegmentierung:

Marktsegmentierung:

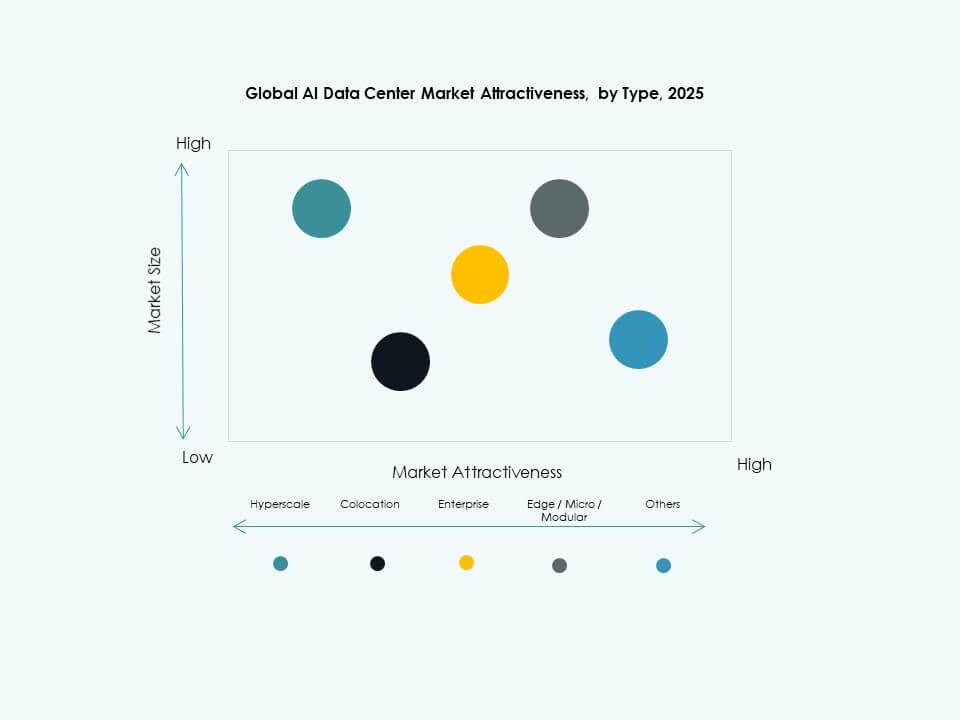

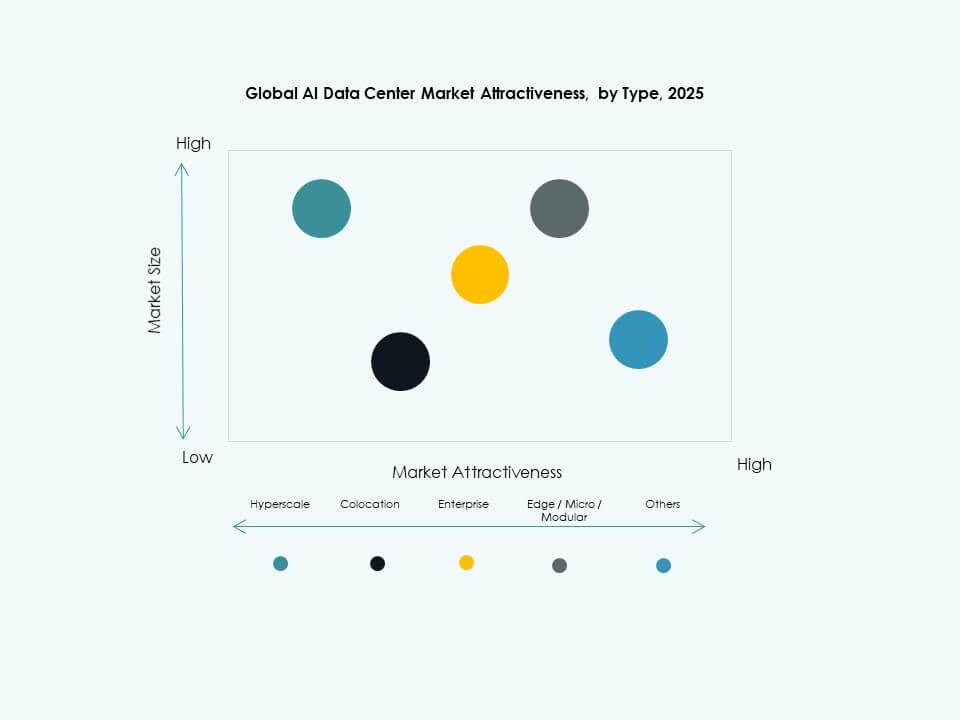

Analyse nach Typsegment

Im globalen Markt für KI-Rechenzentren dominiert das Hyperscale-Segment aufgrund massiver Investitionen von Cloud-Führern in KI-Rechenleistung. Hyperscale-Einrichtungen erfassen den größten Anteil, indem sie Deep Learning, Trainingscluster und Echtzeit-Datenflüsse unterstützen. Colocation & Unternehmen folgt, angetrieben von Unternehmen, die skalierbare KI-Infrastruktur ohne vollständige Ausbauten suchen. Edge/Micro-Rechenzentren zeigen schnelles Wachstum, getrieben durch die Notwendigkeit von KI mit niedriger Latenz am Netzwerkrand. Wichtige Wachstumsfaktoren sind die Cloud-Einführung, die Nachfrage nach verteiltem Rechnen und Investitionen in Hochleistungsserver, die auf KI-Workloads zugeschnitten sind.

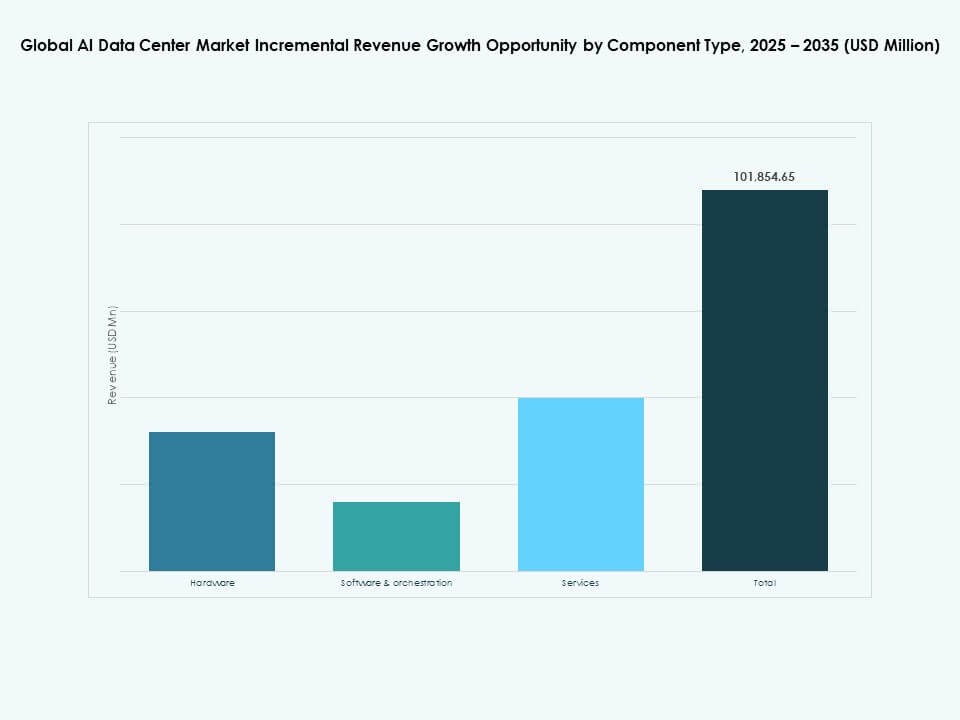

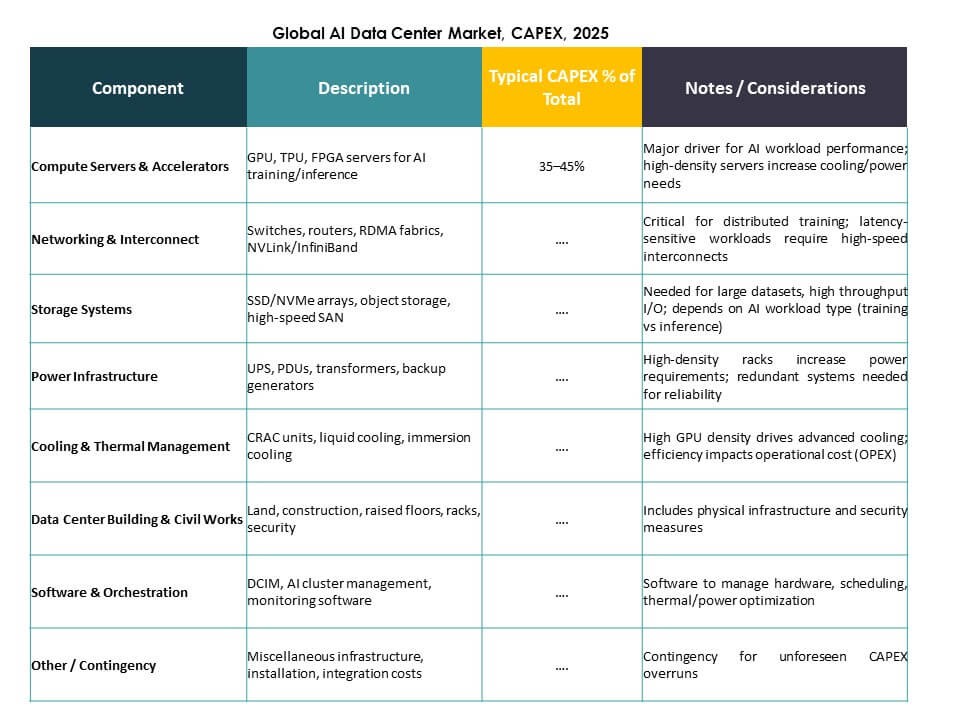

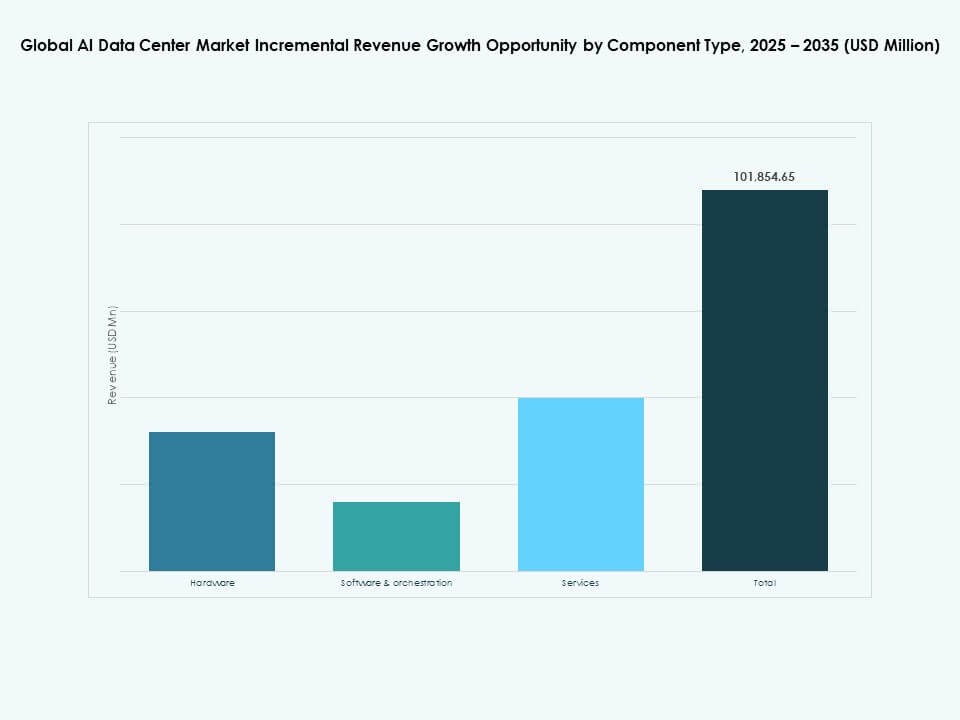

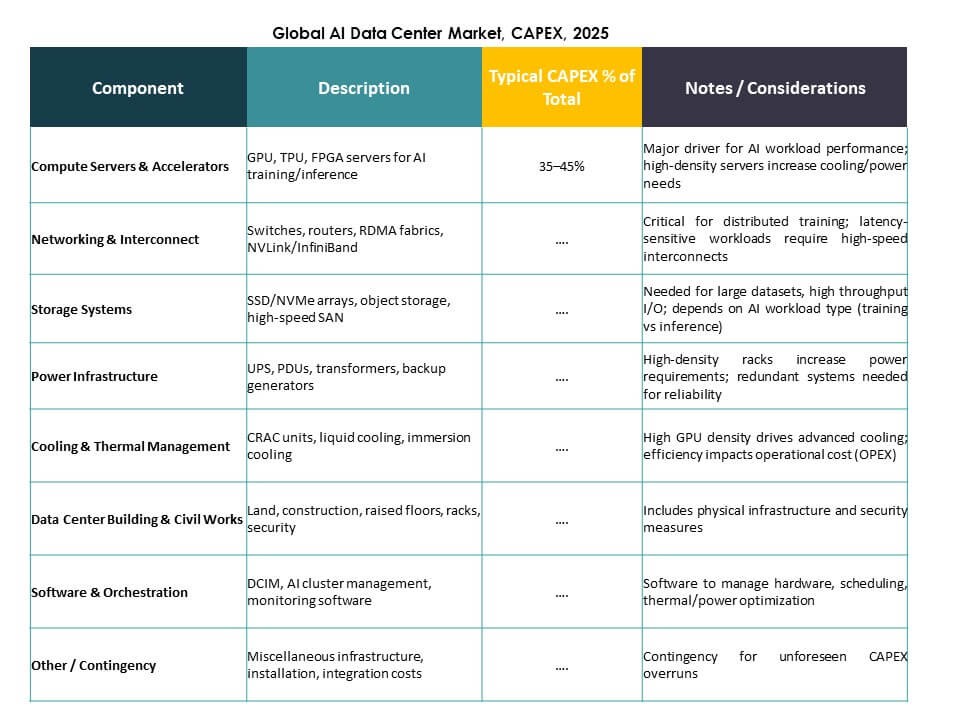

Analyse nach Komponentensegment

Das Hardware-Segment führt im globalen Markt für KI-Rechenzentren, angetrieben durch die Nachfrage nach GPUs, ASICs, Speicherarrays und fortschrittlicher Netzwerkausrüstung. Hardware beansprucht den größten Anteil, da physisches Rechnen für das Training und die Inferenz von KI-Modellen entscheidend bleibt. Software & Orchestrierung wächst schnell mit Tools zur Automatisierung von KI-Workflows und Modellmanagement. Dienstleistungen expandieren ebenfalls, unterstützt durch Integrations-, Wartungs- und Beratungsbedarf. Wachstum resultiert aus beschleunigten KI-Workloads, steigender Infrastrukturkomplexität und dem Bedarf an optimierten Stacks, die Hardware mit KI-Software-Frameworks verbinden.

Analyse nach Bereitstellungssegment

Im globalen Markt für KI-Rechenzentren hält die Cloud-Bereitstellung den größten Anteil aufgrund der skalierbaren, bedarfsgerechten KI-Rechenleistung, die von großen Anbietern angeboten wird. Cloud-basierte KI unterstützt flexible Kapazitäten und globale Reichweite, was Unternehmen und Entwickler anzieht. Hybride Bereitstellungen gewinnen durch ausgewogene Kontrolle und Cloud-Skalierung an Bedeutung, bevorzugt von regulierten Branchen. On-Premise bleibt wichtig für Organisationen, die Datenkontrolle und Sicherheit benötigen. Wachstumstreiber sind digitale Transformation, sensible Datenregulierungen und die Nachfrage nach nahtloser Integration zwischen lokaler Infrastruktur und Cloud-KI-Diensten.

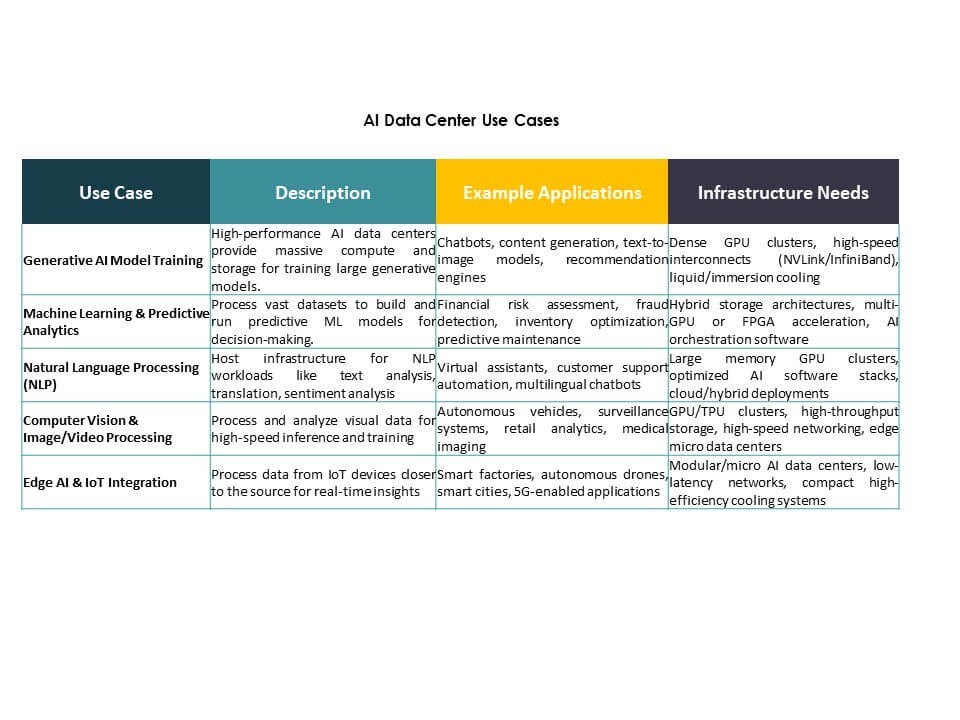

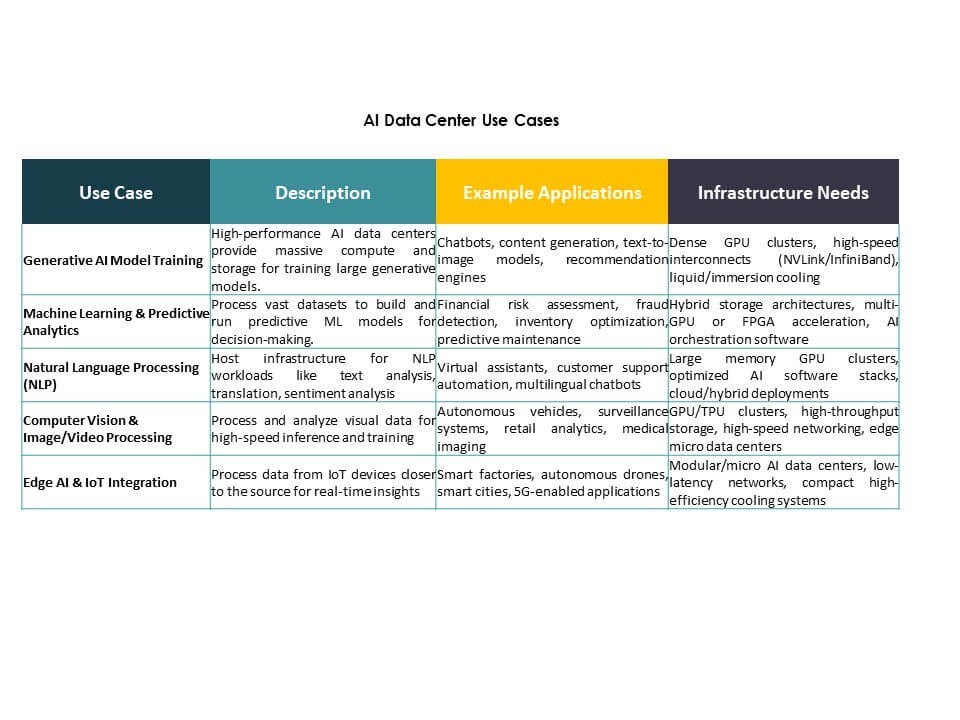

Analyse nach Anwendungssegment

Generative KI (GenAI) erweist sich als das am schnellsten wachsende und dominierende Anwendungssegment im globalen Markt für KI-Rechenzentren, angetrieben durch große Sprachmodelle und die Nachfrage nach Inhaltserstellung. Maschinelles Lernen (ML) behält ebenfalls einen starken Anteil als grundlegende KI-Workloads in verschiedenen Sektoren. NLP und Computer Vision (CV) Segmente expandieren mit Unternehmensanwendungen im Kundenservice und automatisierten Inspektionen. Andere decken spezialisierte KI-Anwendungen ab. Die zunehmende Einführung von KI-Modellen, das Wachstum von konversationeller KI und maßgeschneiderte Lösungen treiben die Expansion in diesen Anwendungssegmenten voran und machen sie zu den Kerntreibern der Nutzung von KI-Rechenzentren.

Analyse nach Vertikalsegment

Im globalen Markt für KI-Rechenzentren führt der IT- und Telekommunikationssektor, unterstützt durch hohen KI-Datenverkehr und Netzwerkoptimierungsbedarf. BFSI folgt, investiert in KI für Betrugserkennung und Kundenanalysen. Gesundheitswesen und Einzelhandel zeigen starkes Wachstum durch die Einführung von KI für Diagnostik und personalisierte Dienstleistungen. Die Automobilindustrie macht Fortschritte mit autonomen Systemen, während Medien & Unterhaltung KI für die Inhaltserstellung nutzen. Die Fertigung profitiert durch vorausschauende Wartung. Die Nachfrage nach intelligenten Lösungen, digitaler Transformation und Automatisierung treibt die vertikale Einführung voran und erweitert die Bereitstellungen von KI-Rechenzentren in verschiedenen Branchen.

Regionale Einblicke:

Nordamerika dominiert den globalen Markt für KI-Datenzentren mit einem Anteil von über 38% im Jahr 2025. Die Vereinigten Staaten führen Investitionen in hyperskalierte KI-Infrastrukturen durch Technologieriesen wie Microsoft, Google, Meta und Amazon an. Diese Unternehmen erweitern GPU-reiche Datenzentren, um generative KI- und maschinelle Lernservices zu unterstützen. Kanada fördert das Wachstum mit günstigen KI-Innovationsrichtlinien und einer starken digitalen Infrastruktur. Initiativen im Bereich Edge-Computing und die Expansion von Cloud-Plattformen verstärken die regionale Dominanz. Marktreife, starke private Investitionen und ein fortschrittliches Ökosystem tragen zur Führungsrolle Nordamerikas bei. Es bleibt das Zentrum für KI-Trainingscluster und Hochleistungsrechneranwendungen.

- Zum Beispiel deckt Microsofts Fairwater KI-Datenzentrum in Mount Pleasant, Wisconsin, 315 Acres mit 1,2 Millionen Quadratfuß Fläche und 337,6 Megawatt Kapazität ab und verfügt über Tausende von miteinander verbundenen NVIDIA GB200 GPUs.

Asien-Pazifik hält den zweitgrößten Anteil mit etwa 30% und ist der am schnellsten wachsende regionale Markt. China investiert in souveräne KI-Infrastrukturen und beschleunigt die Entwicklung inländischer Chips, um die Abhängigkeit von ausländischer Technologie zu verringern. Japan, Südkorea und Indien setzen KI-fähige Cloud-Infrastrukturen ein, unterstützt durch nationale Digitalstrategien. Südostasien trägt durch die steigende Nachfrage nach Colocation und KI-gesteuerten Unternehmensdiensten bei. Regierungen in der Region priorisieren Datenlokalisierung und energieeffiziente Bauten. Es profitiert von großen Bevölkerungszentren, wachsender Cloud-Durchdringung und einer KI-orientierten Unternehmensmentalität. Die Region ist gut positioniert, um durch Partnerschaften zwischen Hyperscalern und lokalen Betreibern zu skalieren.

- Zum Beispiel startete Huawei 2025 CloudMatrix 384, das 384 Ascend 910C KI-Chips in einer Supernode-Architektur integriert, die 300 PetaFLOPS BF16-Compute mit 3,6-facher Speicherkapazität gegenüber Nvidias GB200 NVL72 liefert.

Europa macht fast 22% des globalen Marktes für KI-Datenzentren aus und konzentriert sich auf nachhaltige, regulierungskonforme KI-Infrastrukturen. Deutschland, das Vereinigte Königreich und Frankreich treiben die Nachfrage durch Unternehmens-KI, Edge-Computing und öffentlich-private KI-Initiativen an. Europa setzt strenge Richtlinien für Kohlenstoff, Datenschutz und Souveränität durch, die das Design und den Standort von Datenzentren beeinflussen. Investitionen fließen in grüne KI-Datenzentren mit LEED- und BREEAM-Zertifizierungen. Aufstrebende Märkte in Mittel- und Osteuropa wachsen durch steigende Cloud-Adoption und regionale Expansion durch große Betreiber. Die Region betont KI für industrielle Automatisierung, Gesundheitswesen und Finanzen. Sie bietet langfristige Chancen durch die Entwicklung energieeffizienter, modularer Infrastrukturen.

WettbewerbsEinblicke:

WettbewerbsEinblicke:

- Microsoft (Azure)

- Amazon Web Services (AWS)

- Google Cloud / Alphabet

- Meta Platforms

- NVIDIA

- Dell Technologies

- Hewlett Packard Unternehmen (HPE)

- Lenovo

- IBM

- Equinix

WettbewerbsEinblicke

WettbewerbsEinblicke

Der globale AI-Datenzentrum-Markt zeichnet sich durch eine Mischung aus Hyperscale-Cloud-Anbietern, führenden AI-Hardware-Herstellern und Colocation-Betreibern aus. Microsoft, AWS und Google Cloud führen durch massive Investitionen in AI-optimierte Infrastruktur und globale Reichweite. Meta baut maßgeschneiderte AI-Datenzentren, um proprietäre Modelle und immersive Dienste zu unterstützen. NVIDIA beeinflusst den Markt durch GPU-Führerschaft und Partnerschaften mit großen Betreibern. Dell, HPE und Lenovo unterstützen die Nachfrage von Unternehmen mit skalierbarer, AI-fähiger Hardware und hybriden Lösungen. IBM konzentriert sich auf die Integration von AI-Workloads, während Equinix und Digital Realty Trust die globale AI-Colocation-Kapazität ausbauen. CoreWeave und QTS spezialisieren sich auf hochdichte AI-Umgebungen für das Modelltraining. Der Markt bleibt wettbewerbsfähig, geprägt von Innovationen in Chipsets, Kühlung und Orchestrierungssoftware. Er begünstigt Akteure, die Leistung, Nachhaltigkeit und AI-Skalierbarkeit unter strengen Time-to-Market-Anforderungen in Einklang bringen.

Neueste Entwicklungen:

- Im November 2025 bildete Microsoft eine bedeutende Cloud-Infrastruktur-Partnerschaft mit Anthropic und Nvidia, die $30 Milliarden an Azure-Computing-Kapazitätsverpflichtungen umfasst, um die Fähigkeiten von AI-Datenzentren angesichts sich ändernder Allianzen zu stärken.

Markttreiber

Markttreiber Markttrends

Markttrends Marktherausforderungen

Marktherausforderungen Marktsegmentierung:

Marktsegmentierung: WettbewerbsEinblicke:

WettbewerbsEinblicke: WettbewerbsEinblicke

WettbewerbsEinblicke