Riassunto esecutivo:

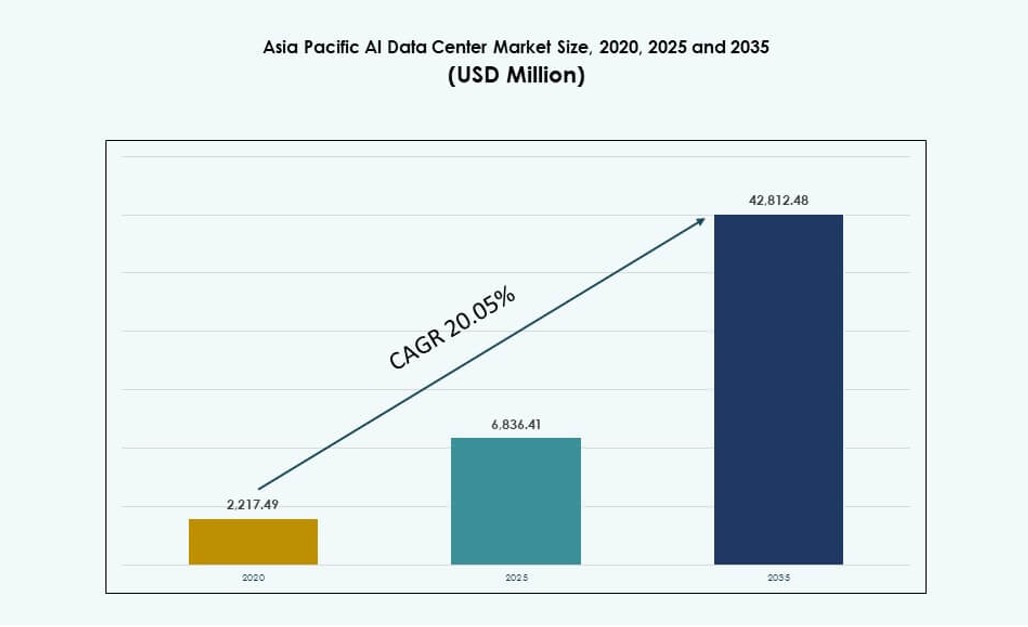

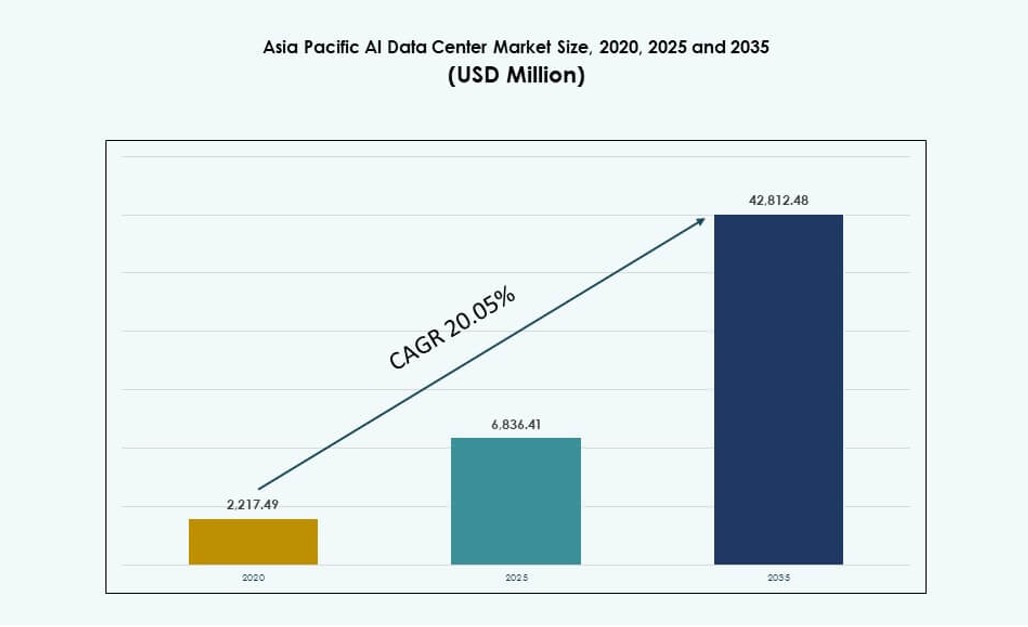

La dimensione del mercato dei Data Center AI dell’Asia Pacifico è stata valutata a 2.217,49 milioni di USD nel 2020, raggiungendo i 6.836,41 milioni di USD nel 2025 e si prevede che raggiungerà i 42.812,48 milioni di USD entro il 2035, con un CAGR del 20,05% durante il periodo di previsione.

| ATTRIBUTO DEL RAPPORTO |

DETTAGLI |

| Periodo Storico |

2020-2023 |

| Anno Base |

2024 |

| Periodo di Previsione |

2025-2035 |

| Dimensione del Mercato dei Data Center AI dell’Asia Pacifico 2025 |

6.836,41 Milioni di USD |

| Mercato dei Data Center AI dell’Asia Pacifico, CAGR |

20,05% |

| Dimensione del Mercato dei Data Center AI dell’Asia Pacifico 2035 |

42.812,48 Milioni di USD |

Il mercato sta avanzando grazie alla crescente domanda di infrastrutture specifiche per l’AI, all’espansione diffusa del cloud e all’adozione di cluster GPU ad alta densità. Le aziende stanno dando priorità agli investimenti in strutture appositamente costruite con raffreddamento ottimizzato, interconnessioni avanzate e piattaforme di orchestrazione AI. I governi stanno sostenendo i quadri nazionali di AI con politiche di cloud sovrano e iniziative per l’economia digitale. L’innovazione nel computing edge e nelle architetture ibride sta rimodellando i modelli di distribuzione dell’infrastruttura. Le aziende hyperscale e i fornitori di colocation stanno allineando i design dei data center per soddisfare le esigenze di formazione e inferenza AI. La regione attira investitori in cerca di rendimenti a lungo termine da infrastrutture AI scalabili e sostenibili.

L’Asia orientale domina il panorama, guidata da Cina, Giappone e Corea del Sud grazie alla forte penetrazione del cloud, alle strategie nazionali di AI e ai cluster tecnologici densi. L’Asia meridionale, in particolare l’India, sta emergendo rapidamente, trainata dall’espansione hyperscale e dalla disponibilità di competenze AI. Il Sud-est asiatico e l’Oceania mostrano un forte slancio, con Singapore, Indonesia e Australia che investono in zone AI e implementazioni edge. La regione bilancia architetture centralizzate e distribuite per soddisfare le normative locali sui dati e le esigenze di latenza. Il mercato dei Data Center AI dell’Asia Pacifico riflette un cambiamento dinamico verso una capacità AI localizzata con driver di crescita regionali che supportano una più ampia trasformazione digitale.

Dinamiche di Mercato:

Driver di Mercato

Aumento delle esigenze di carico di lavoro AI che guida l’infrastruttura GPU ad alta densità e la costruzione di nuove strutture

Il mercato dei Data Center AI dell’Asia Pacifico si sta espandendo rapidamente a causa della crescente domanda di calcolo ad alte prestazioni. I modelli di AI ora richiedono cluster GPU densi e interconnessioni veloci, spingendo i data center a riprogettare l’infrastruttura esistente. Le imprese stanno passando da server tradizionali centrati su CPU a hardware accelerato da GPU e AI. Questo cambiamento hardware aumenta la necessità di efficienza di raffreddamento, ottimizzazione energetica e pianificazione della densità a livello di rack. Gli operatori stanno investendo in ambienti di addestramento e inferenza AI di nuova generazione. Le piattaforme hyperscale e cloud-native stanno dando priorità alla disponibilità di calcolo AI nei hub regionali. L’importanza strategica cresce poiché l’APAC diventa centrale per la scalabilità del deployment AI. Serve sia i player globali che le startup AI locali in cerca di prestazioni, scala e portata.

- ad esempio, le GPU NVIDIA H100 Tensor Core offrono 3.958 teraFLOPS di prestazioni FP8 Tensor Core per GPU.

Adozione Aumentata del Cloud AI e Integrazione delle Piattaforme da Parte di Giganti Tecnologici e Missioni AI Governative

I fornitori di servizi cloud stanno integrando strumenti AI direttamente nelle loro piattaforme, espandendo l’infrastruttura nel processo. Gli hyperscaler come AWS, Google Cloud e Azure stanno stabilendo zone di disponibilità regionali per servire carichi di lavoro AI locali. Offrono pipeline AI pre-costruite, API e ambienti di addestramento che attraggono la domanda di imprese e sviluppatori. Le strategie nazionali AI in tutta l’APAC, inclusi India, Cina e Singapore, accelerano lo sviluppo AI basato su cloud. Le iniziative strategiche finanziano lo sviluppo dei data center, l’infrastruttura AI sovrana e il deployment di cluster GPU. Le imprese preferiscono ambienti di addestramento AI regionalizzati per latenza, governance dei dati e conformità. Il mercato dei Data Center AI dell’Asia Pacifico beneficia di questa convergenza di cloud, AI e politiche nazionali. Posiziona la regione come piattaforma di lancio preferita per iniziative AI su scala aziendale.

- Ad esempio, il supercomputer AIRAWAT-PSAI dell’India include 656 GPU NVIDIA A100 e supporta 410 petaflops di capacità di calcolo AI. Serve come infrastruttura nazionale di ricerca AI nell’ambito delle missioni AI e supercomputing dell’India.

Crescita nelle Applicazioni AI Specifiche per Settore nei Verticali di Telecomunicazioni, Sanità e Manifattura

Le aziende di telecomunicazioni stanno implementando AI per ottimizzare l’infrastruttura 5G, il network slicing e l’elaborazione edge. Nel settore sanitario, i fornitori utilizzano AI per migliorare la diagnostica, l’imaging e l’automazione del flusso di lavoro ospedaliero. Le aziende manifatturiere sfruttano l’analitica guidata da AI per la manutenzione predittiva, il rilevamento dei difetti e il controllo della robotica. Questa adozione settoriale porta a costruzioni di data center specifiche per verticale. Gli operatori ora co-localizzano ambienti AI vicino ai centri di produzione o ai campus di ricerca. I cicli di addestramento AI richiedono bassa latenza, capacità di inferenza edge e backhaul ad alta velocità. I nuovi carichi di lavoro nella visione artificiale e nell’analitica in tempo reale mettono sotto pressione le strutture tradizionali. Il mercato dei Data Center AI dell’Asia Pacifico affronta queste esigenze verticali con capacità e modelli di deployment su misura. Diventa parte integrante della trasformazione digitale nei principali settori.

Distribuzioni di Edge AI e Micro Data Center che Trasformano i Modelli di Consegna dell’Infrastruttura nei Centri Urbani

La domanda di inferenza a bassa latenza nel settore retail, nella mobilità e nell’IoT porta a implementazioni distribuite. I modelli di AI edge richiedono un’elaborazione rapida dei dati vicino ai punti finali degli utenti. Paesi come il Giappone, la Corea del Sud e l’Australia vedono una precoce adozione di micro data center pronti per l’edge. Catene di vendita al dettaglio, sistemi autonomi e infrastrutture cittadine integrano l’AI per operazioni intelligenti. Queste tendenze spostano gli investimenti dall’addestramento centralizzato verso l’esecuzione decentralizzata. I nuovi formati includono nodi AI containerizzati, unità edge modulari e pod retail intelligenti. Si connettono ai nodi cloud centrali tramite fibra e 5G, formando topologie ibride. Il mercato dei data center AI dell’Asia Pacifico beneficia di questa integrazione edge-core, abilitando servizi reattivi e nativi dell’AI nelle città. Supporta settori critici che richiedono decisioni istantanee e intelligenti.

Tendenze di Mercato

Adozione Crescente del Raffreddamento a Liquido per Abilitare Densità di Rack da 40–100 kW nei Carichi di Lavoro AI

I sistemi di raffreddamento ad aria affrontano limitazioni nella gestione dei crescenti carichi termici dai server AI basati su GPU. Il raffreddamento a liquido, in particolare il raffreddamento diretto al chip e gli scambiatori di calore posteriori, guadagna slancio. Gli operatori ristrutturano o riprogettano le loro strutture per supportare 40–100 kW per rack. Questo cambiamento consente cluster AI densi per l’addestramento di modelli di base di grandi dimensioni. I data center a Singapore, India e Corea del Sud sono i primi ad adottare rack raffreddati a liquido. I fornitori di tecnologia offrono sistemi modulari compatibili con retrofit e costruzioni greenfield. Anche il dispiegamento del raffreddamento a immersione per carichi di lavoro AI HPC si sta espandendo. Il mercato dei data center AI dell’Asia Pacifico riflette questa transizione termica man mano che l’AI diventa più intensiva dal punto di vista computazionale. Guida il capex verso operazioni sostenibili e ad alta densità.

Integrazione di Interconnessioni Specifiche per AI e Infrastrutture Compatibili con NVLink per Migliorare l’Efficienza del Calcolo

Le interconnessioni ad alta larghezza di banda sono fondamentali per collegare le GPU nei cluster AI. Le strutture ora richiedono topologie che supportano NVIDIA NVLink, PCIe Gen5 e miglioramenti Ethernet/Fabric. Queste caratteristiche consentono l’addestramento di modelli su più nodi con latenza minima e alta velocità di trasmissione. I centri emergenti supportano supercomputer AI, inferenza su larga scala e ottimizzazione multi-GPU. I fornitori integrano strumenti di orchestrazione consapevoli della topologia per ridurre i tempi di addestramento. Il dispiegamento di RDMA e strati di rete intelligenti migliora le prestazioni per i lavori AI distribuiti. Il mercato dei data center AI dell’Asia Pacifico si evolve per supportare queste specifiche per clienti hyperscale e colocation. Migliora la competitività regionale per le implementazioni globali di AI.

Spostamento Verso Suite di Colocation Ottimizzate per AI con Zone di Calcolo e Termiche Pre-Provviste

I fornitori di colocation stanno sviluppando zone AI dedicate con potenza, raffreddamento e impronte di rack pre-approvate. Queste suite si rivolgono ai clienti che desiderano un’implementazione rapida senza cicli di riprogettazione. Tali zone includono cablaggio strutturato, rack pronti per GPU e gestione dell’aria migliorata o compatibilità con liquidi. I clienti beneficiano di tempi di approvvigionamento ridotti e supporto prevedibile per i carichi di lavoro AI. Regioni come Hong Kong e Tokyo sono leader nella colocation AI pronta per l’implementazione. Le piccole imprese utilizzano queste zone per testare e addestrare LLM più piccoli senza capex hyperscale. Il mercato dei data center AI dell’Asia Pacifico riflette questa modularizzazione dei servizi di colocation su misura per i clienti AI. Supporta modelli di adozione ibridi su larga scala.

Emergenza di Zone AI Sovrane Supportate da Cloud Nazionali AI e Quadri di Ricerca

I governi stanno finanziando centri dati con infrastrutture sicure per lo sviluppo di modelli di IA sotto quadri sovrani. Queste zone supportano modelli linguistici nazionali, iniziative di IA industriali e addestramento di dati regolamentato. I partner infrastrutturali implementano cluster GPU sicuri con accesso limitato e pipeline di IA controllate. Esempi includono l’iniziativa Bhashini dell’India e le zone di IA provinciali della Cina. Questi sviluppi creano una domanda localizzata per il calcolo nativo di IA all’interno dei confini nazionali. Gli operatori lavorano con istituzioni pubbliche per allineare l’infrastruttura agli obiettivi politici. Il mercato dei centri dati di IA dell’Asia Pacifico incorpora questa collaborazione tra governo e industria nella sua struttura. Posiziona la regione come leader nella prontezza sovrana dell’IA.

Sfide del Mercato

Vincoli di Potenza, Scarsità di Terreno e Pressioni Ambientali nei Densi Cluster Urbani di IA

La disponibilità di energia è diventata un collo di bottiglia in città come Tokyo, Singapore e Seoul. I centri dati di IA richiedono carichi di potenza elevati e stabili, ma le reti urbane affrontano esigenze concorrenti. La scarsità di terreno e le rigide normative urbanistiche rendono difficili le nuove costruzioni. I ritardi nei permessi spesso ostacolano le tempistiche di costruzione su larga scala. Gli operatori devono navigare tra regolamenti energetici in evoluzione e obiettivi di carbonio. I sistemi di raffreddamento a liquido richiedono anche significative risorse idriche in alcuni progetti. I mandati di sostenibilità creano tensione tra gli obiettivi di densità e le limitazioni delle risorse. Il mercato dei centri dati di IA dell’Asia Pacifico deve risolvere queste sfide per mantenere il suo slancio di crescita. È necessaria una coordinazione a lungo termine con enti di servizi pubblici, municipali e regolatori.

Accesso Limitato all’Hardware e al Talento Capace di IA Rallenta i Tempi di Implementazione nelle Economie in Sviluppo

Le lacune nella catena di approvvigionamento limitano l’accesso tempestivo a GPU di fascia alta come NVIDIA H100 o AMD MI300. I paesi più piccoli nel Sud-est asiatico e nell’Asia meridionale faticano a garantire questi componenti. I tempi di consegna prolungano l’implementazione e limitano l’innovazione al di fuori dei principali hub. Allo stesso modo, la mancanza di ingegneri formati e architetti di infrastrutture di IA ritarda la prontezza dei progetti. I mercati emergenti affrontano carenze di competenze nell’orchestrazione, nel monitoraggio e nell’ottimizzazione dei carichi di lavoro. I fornitori di cloud offrono servizi di IA gestiti, ma questi dipendono ancora dalla disponibilità dell’infrastruttura di base. Il mercato dei centri dati di IA dell’Asia Pacifico sperimenta una crescita disomogenea dove l’accesso a talento e hardware rimane basso. Affrontare questo richiede formazione regionale e partnership strategiche con i fornitori.

Opportunità di Mercato

Espansione dell’IA Aziendale tra le Imprese di Medie Dimensioni che Guida la Domanda di Colocation e Implementazione Ibrida

Le imprese nei settori manifatturiero, logistico e retail stanno ampliando i team interni di IA. Queste aziende richiedono ambienti di calcolo scalabili ma convenienti. La colocation pronta per l’IA offre flessibilità con elevate prestazioni e bassi costi di capitale. Gli operatori regionali offrono pacchetti hardware GPU, orchestrazione e funzionalità di conformità. Questo apre alla crescita nelle città oltre i principali hub di livello 1. Il mercato dei centri dati di IA dell’Asia Pacifico supporta queste esigenze attraverso capacità modulari e modelli di servizio ibridi. Si allinea con la digitalizzazione delle PMI e l’innovazione specifica del settore.

Investimenti del Settore Pubblico nell’Infrastruttura di Ricerca sull’IA Creano una Domanda Regionale a Lungo Termine

I governi nazionali finanziano centri di IA collegati all’istruzione, alla difesa e alla salute pubblica. Questi centri richiedono cluster GPU stabili e calcolo localizzato. Le partnership infrastrutturali garantiscono prestazioni, sicurezza e conformità alla residenza dei dati. Gli operatori allineano le offerte agli obiettivi di ricerca pubblica. Il mercato dei Data Center per l’IA dell’Asia Pacifico beneficia di questo ciclo di investimenti costante. Sostiene la domanda attraverso linee temporali politiche e fiscali.

Segmentazione del Mercato

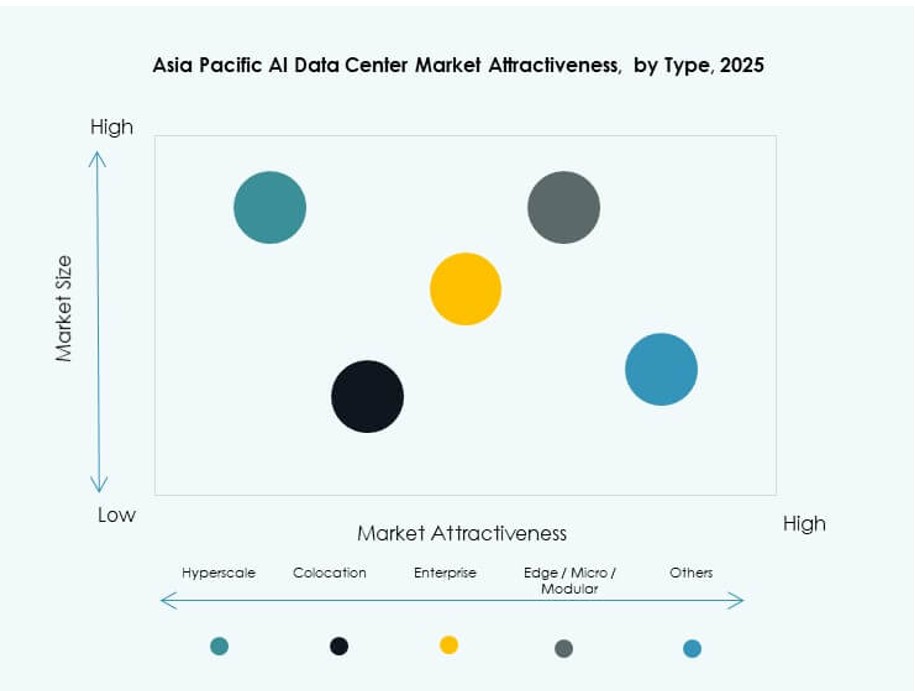

Per Tipo

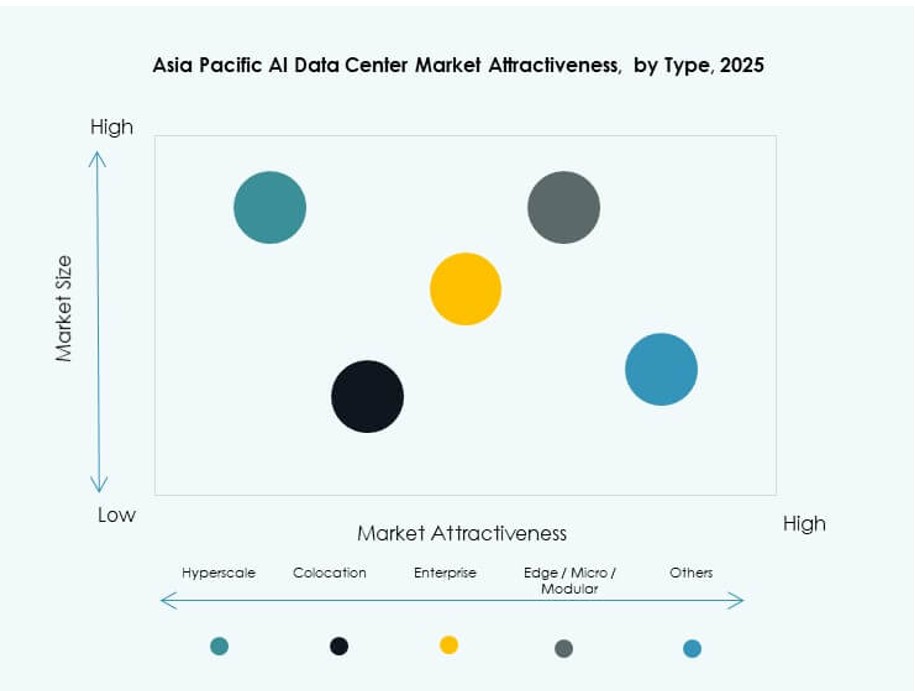

I data center hyperscale dominano il mercato dei Data Center per l’IA dell’Asia Pacifico con una quota significativa grazie ai grandi investimenti delle aziende globali di cloud e IA. Queste strutture offrono una scala massiccia, alta densità di GPU e integrazione con acceleratori di IA. Le implementazioni di colocation e aziendali rimangono forti nelle metropoli con ambienti di IA regolamentati. I data center edge e micro stanno crescendo nel Sud-Est asiatico per soddisfare i requisiti di bassa latenza per applicazioni al dettaglio, mobilità e città intelligenti.

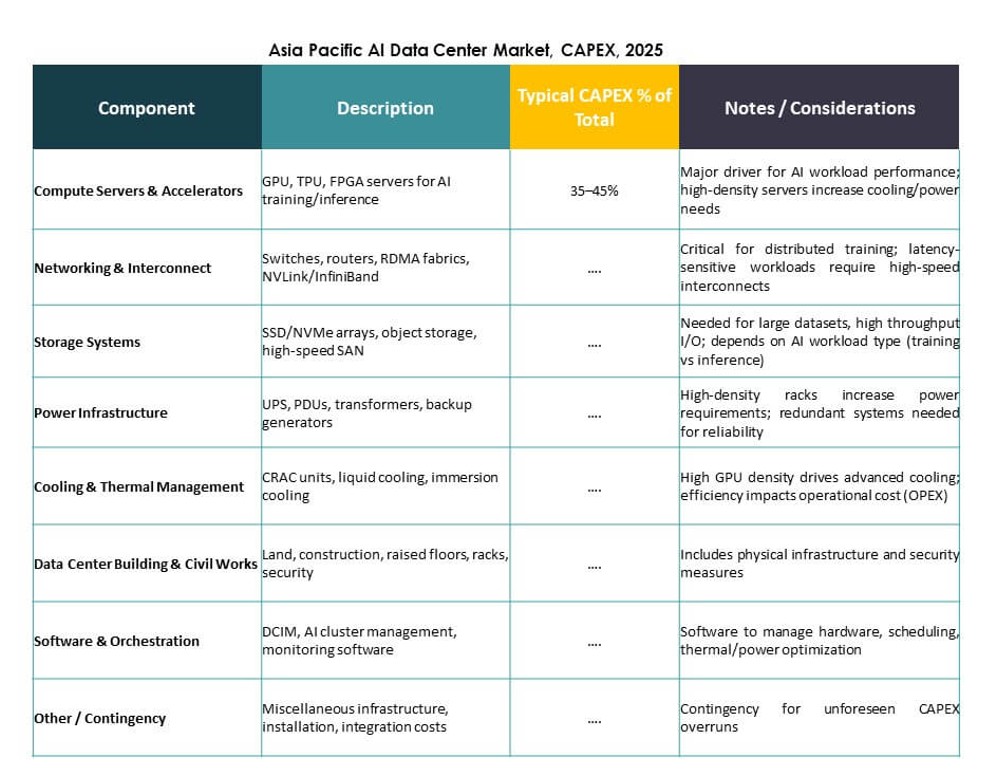

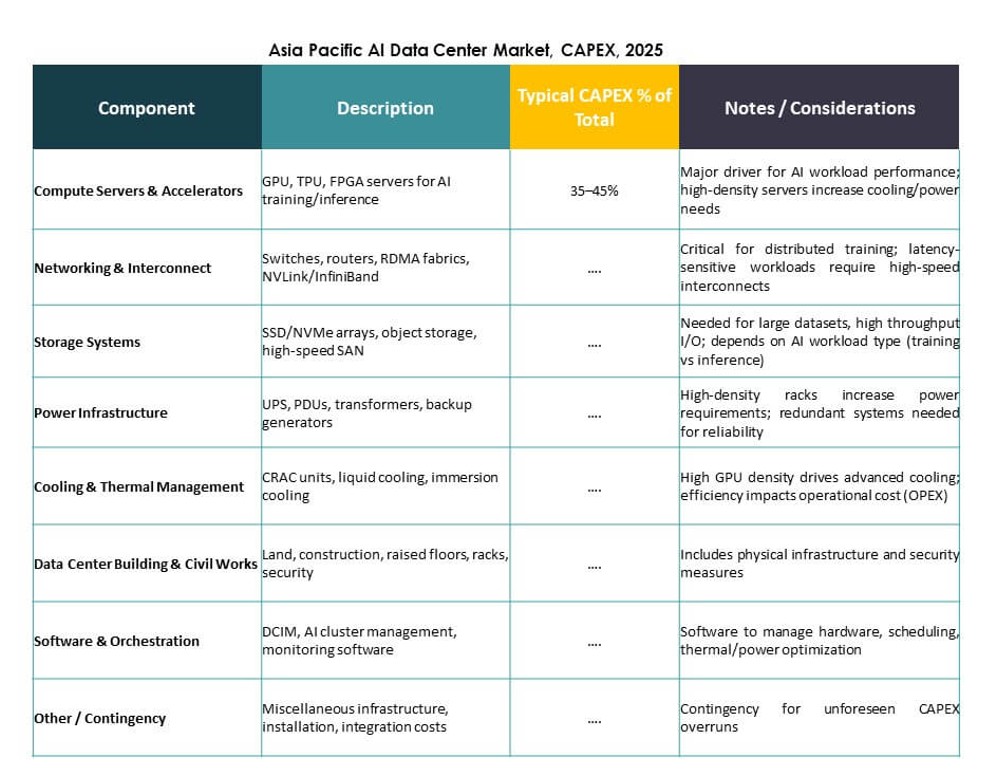

Per Componente

L’hardware rappresenta la quota maggiore a causa delle ampie esigenze di GPU, CPU e storage per i carichi di lavoro di IA. I principali investimenti mirano a interconnessioni ad alta larghezza di banda, moduli di alimentazione e gestione termica. Il software e l’orchestrazione stanno guadagnando terreno poiché l’addestramento dell’IA richiede una pianificazione avanzata dei carichi di lavoro, scalabilità dei cluster e gestione dei container. Il segmento dei servizi cresce con la domanda di progettazione, consulenza e operazioni gestite in ambienti specifici per l’IA.

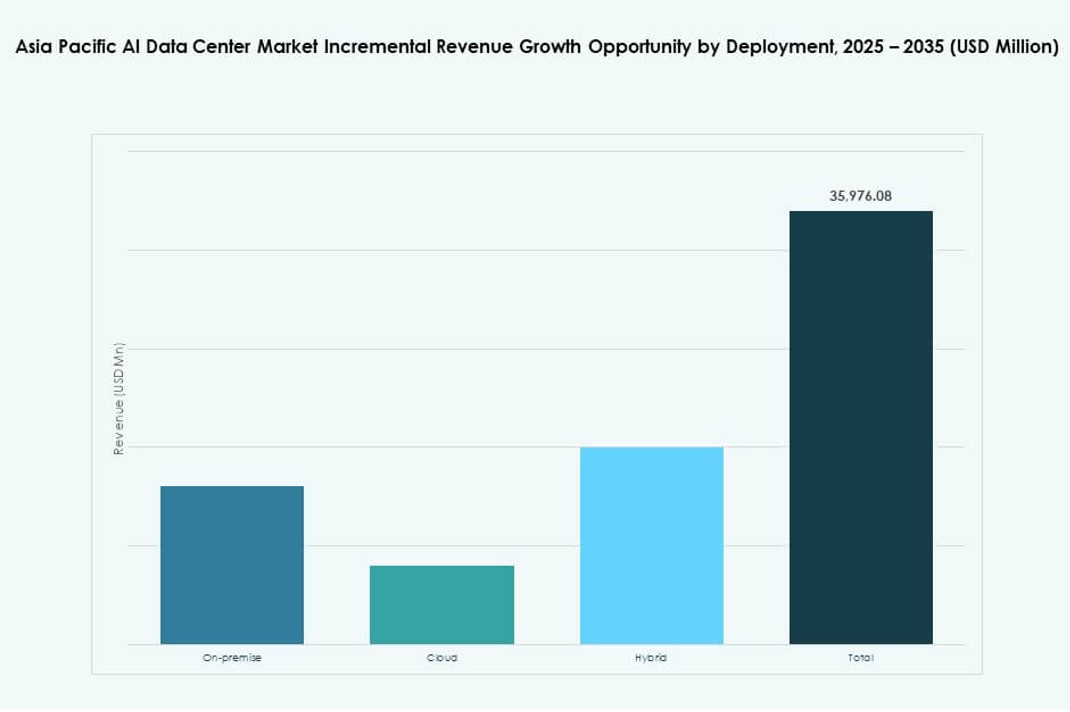

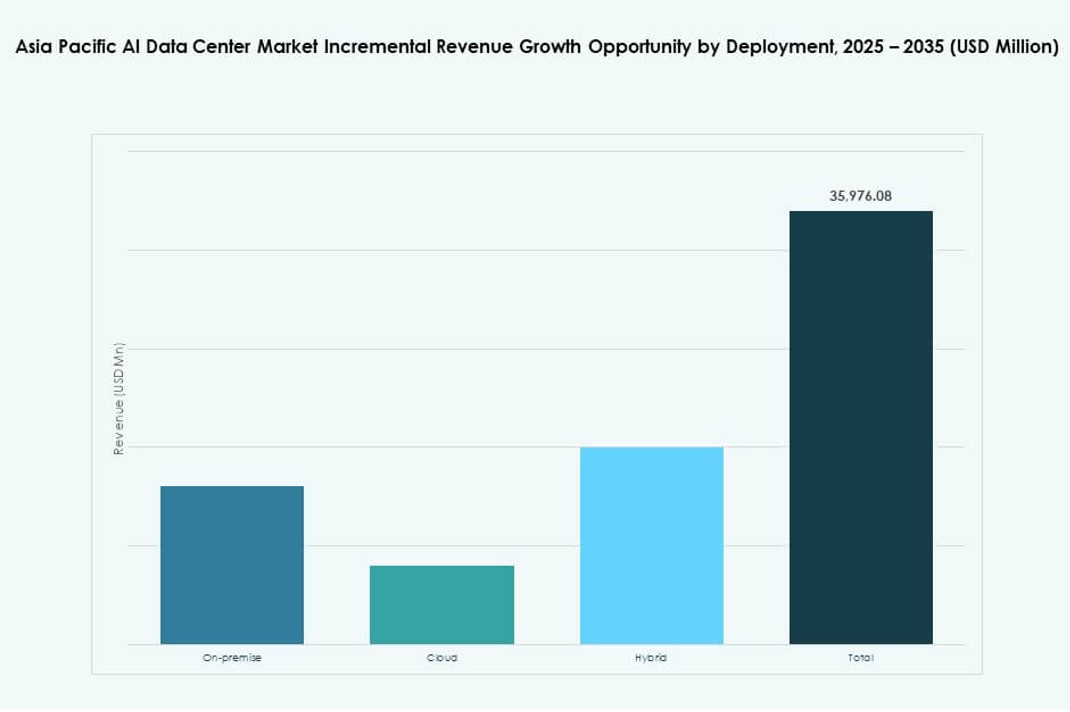

Per Implementazione

L’implementazione di IA basata su cloud guida il mercato, trainata dall’espansione degli hyperscaler e dall’adozione da parte delle PMI di infrastrutture di IA gestite. L’on-premise rimane rilevante per le industrie regolamentate e l’addestramento dell’IA in ambienti controllati. I modelli di implementazione ibrida stanno aumentando poiché le aziende bilanciano la scalabilità del cloud con l’inferenza basata su edge e casi d’uso sensibili alla latenza. Il mercato dei Data Center per l’IA dell’Asia Pacifico si allinea con i vari livelli di maturità aziendale nelle subregioni.

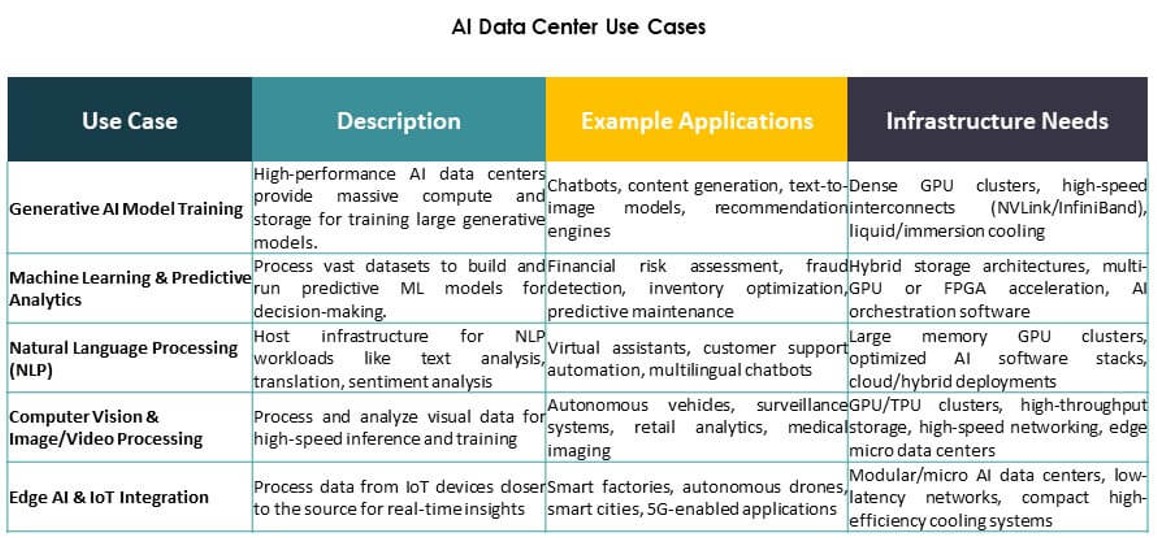

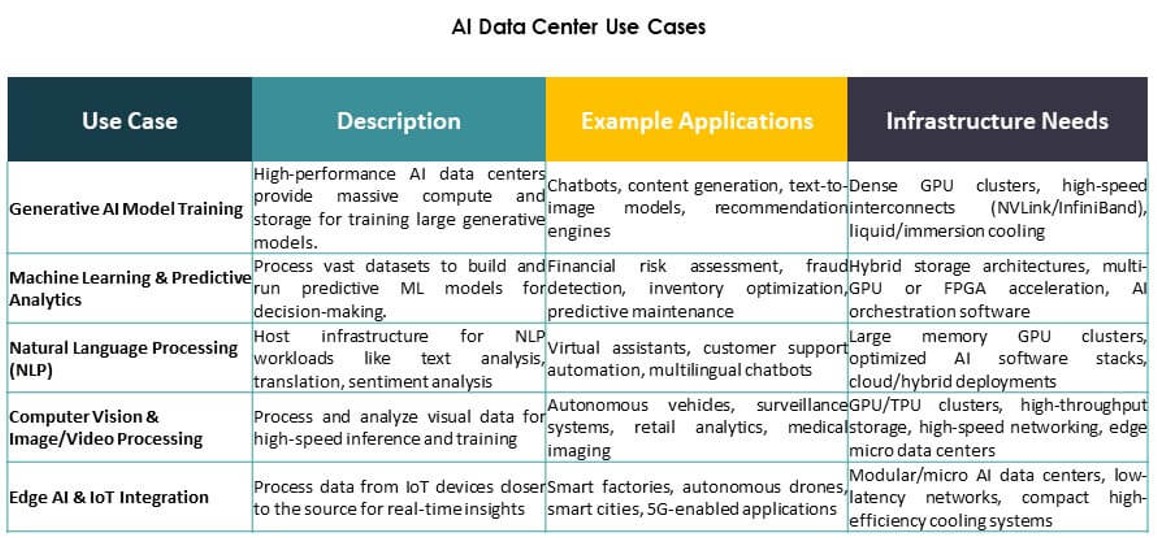

Per Applicazione

Il Machine Learning detiene la quota di applicazione più grande, specialmente nell’IA aziendale e nell’analisi industriale. L’IA generativa è il segmento in più rapida crescita, alimentato dall’addestramento di modelli di base e dall’inferenza LLM. La Computer Vision guida la domanda nella sorveglianza, nel retail e nell’automazione industriale. L’NLP alimenta i centri di contatto, i chatbot e gli strumenti di traduzione. Altre applicazioni includono motori di raccomandazione e previsioni di serie temporali nei settori BFSI e logistica.

Per Settore

L’IT e le Telecomunicazioni guidano la segmentazione verticale, trainate dall’infrastruttura centrale di IA e dai casi d’uso di ottimizzazione del 5G. I settori BFSI e Retail seguono da vicino, concentrandosi su rilevamento delle frodi, personalizzazione e servizi di chatbot. La sanità sta emergendo con una rapida crescita nella diagnostica IA e nell’automazione ospedaliera. La domanda nei settori automobilistico e manifatturiero cresce con la produzione guidata dall’IA, la robotica e la R&S. Il mercato dei Data Center per l’IA dell’Asia Pacifico supporta la trasformazione intersettoriale attraverso infrastrutture allineate verticalmente.

Approfondimenti Regionali

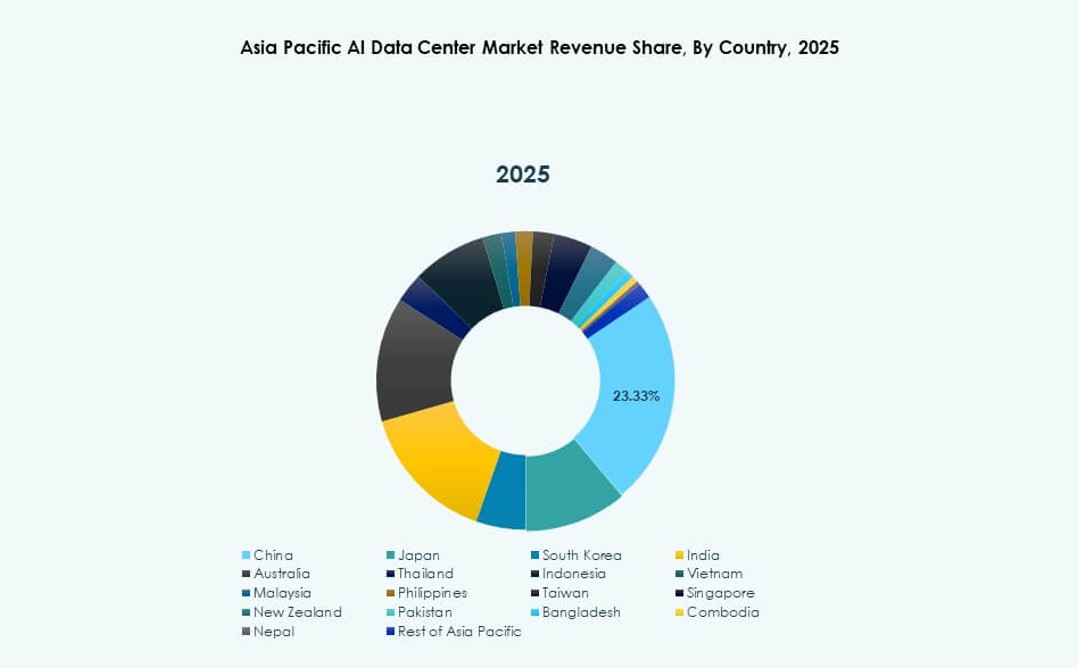

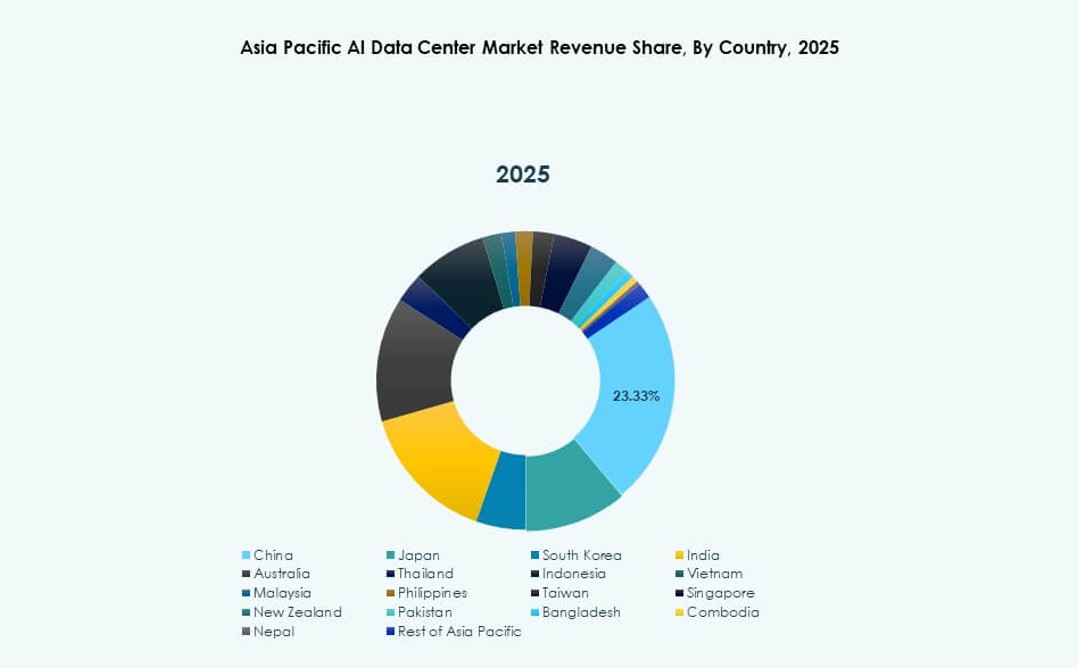

L’Asia Orientale domina con oltre il 42% della quota di mercato guidata da Cina, Giappone e Corea del Sud

L’Asia orientale detiene la quota maggiore del mercato dei data center AI dell’Asia Pacifico con oltre il 42%. La Cina guida con ingenti investimenti pubblici e privati in hub di supercalcolo AI. Giappone e Corea del Sud contribuiscono attraverso la robotica, l’edge AI e l’esecuzione di politiche nazionali sull’AI. Questi paesi beneficiano di cluster tecnologici urbani densi, una forte infrastruttura energetica e ecosistemi di semiconduttori. Le implementazioni AI su larga scala e sovrane convergono qui per guidare la leadership regionale. Rimane l’ancora dell’infrastruttura AI nell’APAC.

- Ad esempio, il modello Tongyi Qianwen (Qwen-7B) di Alibaba Cloud ha raggiunto un punteggio di 56.7 nel benchmark MMLU su 57 compiti nel 2023.

L’Asia meridionale emerge con oltre il 26% di quota trainata dall’espansione del cloud e dalla base di talenti dell’India

L’Asia meridionale rappresenta oltre il 26% del mercato dei data center AI dell’Asia Pacifico. L’India è il pilastro di questa crescita con una forte base di sviluppatori, zone cloud su larga scala e quadri nazionali sull’AI. Gli investimenti di AWS, Microsoft e aziende locali accelerano le capacità di training e inferenza. Bangladesh e Pakistan sono agli inizi dello sviluppo ma mostrano domanda da fintech e sanità. L’Asia meridionale guadagna trazione grazie all’accessibilità, ai talenti qualificati e alla crescente domanda aziendale. Si evolve in un hub regionale di calcolo AI.

- Ad esempio, a settembre 2023, Reliance Jio ha collaborato con NVIDIA per costruire infrastrutture AI in India utilizzando i superchip NVIDIA GH200 Grace Hopper e i sistemi DGX Cloud. La collaborazione supporta carichi di lavoro AI su larga scala attraverso data center pronti per l’AI gestiti da Jio Platforms.

Sud-est asiatico e Oceania catturano quasi il 32% di quota supportati da posizione strategica e prontezza AI

Il sud-est asiatico e l’Oceania insieme detengono quasi il 32% della quota di mercato. Singapore, Indonesia e Australia guidano la distribuzione dell’infrastruttura attraverso partnership regionali sull’AI. Le implementazioni edge, l’integrazione del 5G e l’innovazione nel raffreddamento sostenibile si distinguono. Thailandia, Vietnam e Filippine vedono forti casi d’uso di GenAI e edge AI nel commercio e nell’educazione. Questa subregione bilancia l’accesso globale al cloud e l’innovazione localizzata. Il mercato dei data center AI dell’Asia Pacifico beneficia della sua centralità e della forza dell’ecosistema digitale.

Approfondimenti Competitivi:

- ST Telemedia Data Centres

- Princeton Digital Group

- AirTrunk

- Microsoft (Azure)

- Amazon Web Services (AWS)

- Google Cloud

- Meta Platforms

- NVIDIA

- Dell Technologies

- Equinix

Il mercato dei data center AI dell’Asia Pacifico è altamente competitivo, modellato da hyperscaler, fornitori di colocation regionali e fornitori di hardware globali. Operatori come ST Telemedia, Princeton Digital e AirTrunk guidano la distribuzione delle strutture nei paesi ad alta crescita. I giganti del cloud, tra cui Microsoft, AWS e Google, continuano ad espandere le zone di training AI tra nodi urbani ed edge. Meta e NVIDIA spingono la domanda attraverso la scalabilità dei modelli di base e l’integrazione hardware. Leader dell’hardware come Dell ed Equinix consentono flessibilità infrastrutturale, allineandosi con i carichi di lavoro AI in evoluzione. Le aziende competono sull’innovazione del raffreddamento, l’efficienza energetica e la densità di calcolo specifica per l’AI. Rimane dinamico, con una forte espansione regionale, partnership di ecosistema e allineamento delle zone AI sovrane che guidano una competizione sostenuta.

Sviluppi Recenti:

- In ottobre 2025, AirTrunk ha formato una partnership strategica con Humain e Blackstone per sviluppare data center AI di nuova generazione in Arabia Saudita, iniziando con un investimento di 3 miliardi di dollari in un campus mirato all’infrastruttura hyperscale e AI.

- In ottobre 2025, Aligned Data Centers è stata acquisita da BlackRock e MGX in un accordo da record di 40 miliardi di dollari che si colloca tra le maggiori acquisizioni infrastrutturali di sempre. La transazione espanderà la presenza di Aligned e accelererà il suo dispiegamento di data center ottimizzati per hyperscale e AI a livello globale.

- In aprile 2025, ST Telemedia Global Data Centres ha lanciato un campus di data center pronto per l’AI a Kolkata, India, con un investimento di 450 crore INR per supportare i crescenti carichi di lavoro AI nella regione dell’Asia Pacifico.