Executive Resumé:

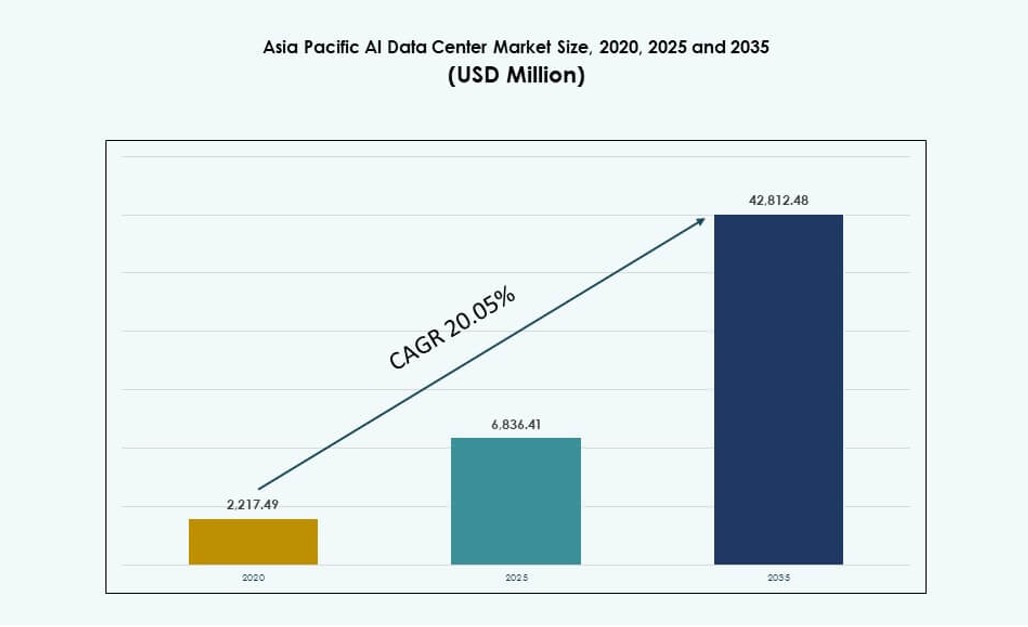

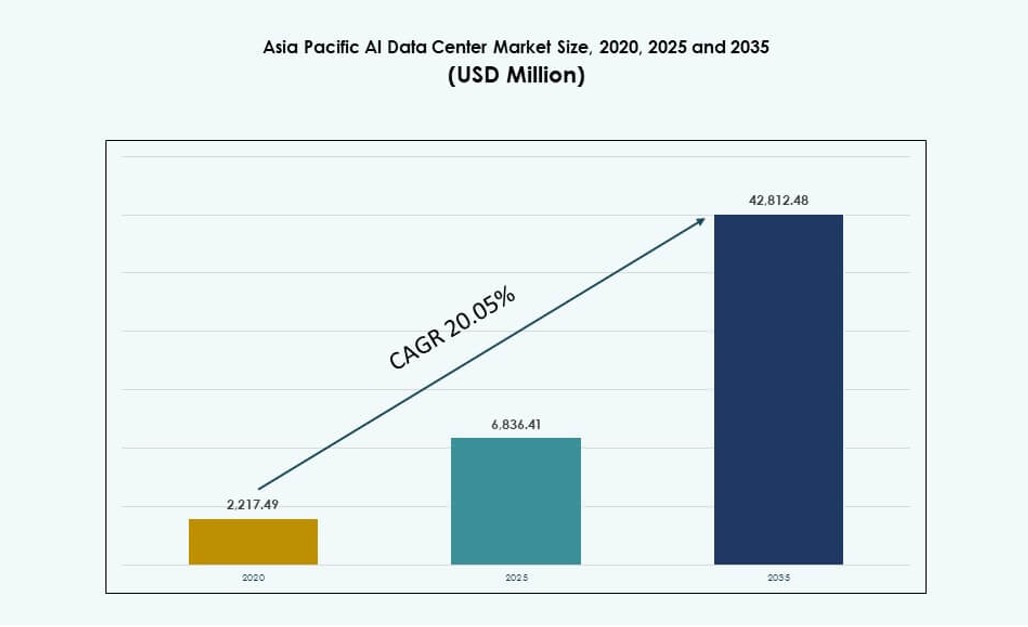

Asien og Stillehavsområdets AI-datacentermarked blev vurderet til USD 2.217,49 millioner i 2020 til USD 6.836,41 millioner i 2025 og forventes at nå USD 42.812,48 millioner i 2035, med en CAGR på 20,05% i prognoseperioden.

| RAPPORTATTRIBUT |

DETALJER |

| Historisk Periode |

2020-2023 |

| Basisår |

2024 |

| Prognoseperiode |

2025-2035 |

| Asien og Stillehavsområdets AI-datacentermarked Størrelse 2025 |

USD 6.836,41 Millioner |

| Asien og Stillehavsområdets AI-datacentermarked, CAGR |

20,05% |

| Asien og Stillehavsområdets AI-datacentermarked Størrelse 2035 |

USD 42.812,48 Millioner |

Markedet udvikler sig på grund af stigende efterspørgsel efter AI-specifik infrastruktur, udbredt cloud-udvidelse og adoption af høj-densitet GPU-klynger. Virksomheder prioriterer investeringer i specialbyggede faciliteter med optimeret køling, avancerede forbindelser og AI-orkestreringsplatforme. Regeringer støtter nationale AI-rammer med suveræne cloud-politikker og digitale økonomi-initiativer. Innovation inden for edge computing og hybride arkitekturer omformer infrastrukturleveringsmodeller. Hyperscale-virksomheder og colocation-udbydere tilpasser datacenterdesign til at imødekomme AI-trænings- og inferenskrav. Regionen tiltrækker investorer, der søger langsigtede afkast fra skalerbar, bæredygtig AI-infrastruktur.

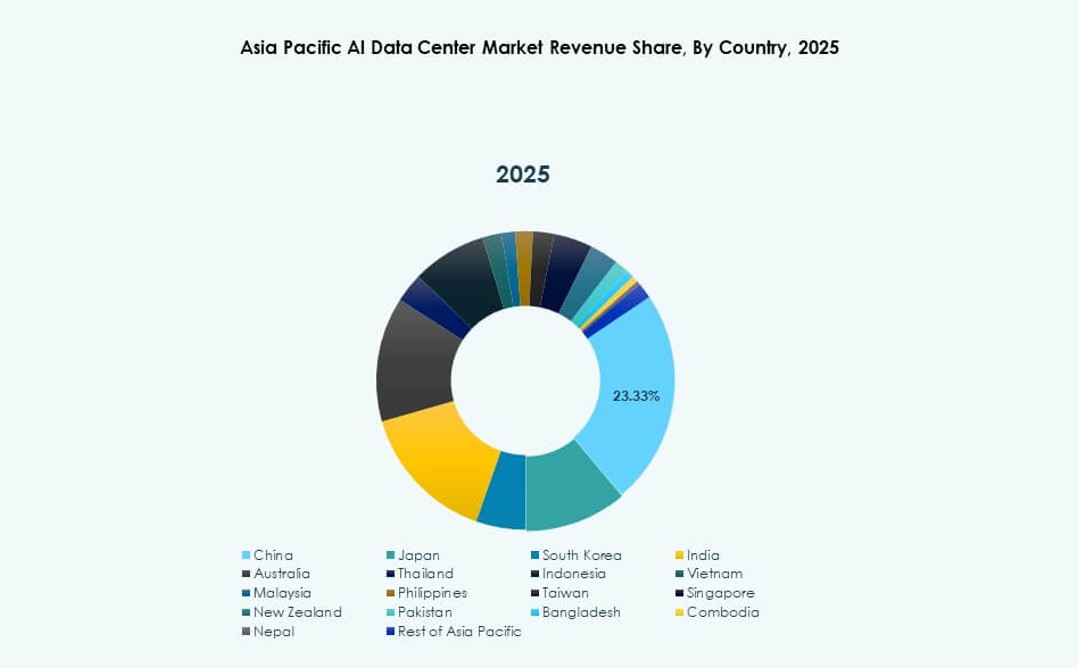

Østasien dominerer landskabet, ledet af Kina, Japan og Sydkorea på grund af stærk cloud-penetration, nationale AI-strategier og tætte teknologiklynger. Sydasien, især Indien, vokser hurtigt, drevet af hyperscale-udvidelse og tilgængelighed af AI-kompetencer. Sydøstasien og Oceanien viser stærkt momentum, med Singapore, Indonesien og Australien, der investerer i AI-zoner og edge-implementeringer. Regionen balancerer centraliserede og distribuerede arkitekturer for at opfylde lokale datalovgivninger og latenstidsbehov. Asien og Stillehavsområdets AI-datacentermarked afspejler et dynamisk skift mod lokaliseret AI-kapacitet med regionale vækstdrivere, der understøtter bredere digital transformation.

Markedsdynamik:

Markedsdrivere

Stigning i AI-arbejdsbelastningskrav driver høj-densitet GPU-infrastruktur og nye facilitetbyggerier

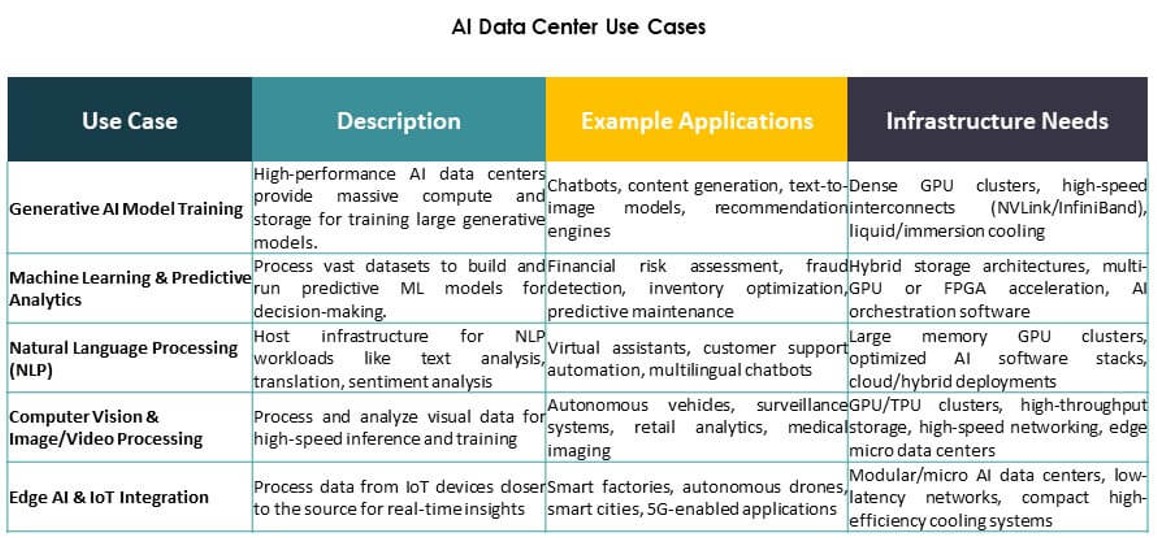

Det asiatiske og stillehavsområde AI-datacentermarkedet udvider sig hurtigt på grund af den stigende efterspørgsel efter højtydende computing. AI-modeller kræver nu tætte GPU-klynger og hurtige forbindelser, hvilket får datacentre til at redesigne eksisterende infrastruktur. Virksomheder skifter fra traditionelle CPU-centrerede servere til GPU- og AI-accelereret hardware. Dette hardwareshift øger behovet for køleeffektivitet, energioptimering og planlægning af rack-niveau tæthed. Operatører investerer i næste generations AI-trænings- og inferensmiljøer. Hyperscale og cloud-native platforme prioriterer tilgængeligheden af AI-compute på tværs af regionale knudepunkter. Strategisk betydning stiger, da APAC bliver central for AI-implementeringsskalerbarhed. Det tjener både globale aktører og lokale AI-startups, der søger ydeevne, skala og rækkevidde.

- for eksempel leverer NVIDIA H100 Tensor Core GPU’er 3.958 teraFLOPS af FP8 Tensor Core ydeevne pr. GPU.

Øget Cloud AI-adoption og platformintegration af teknologigiganter og regerings AI-missioner

Cloud-tjenesteudbydere integrerer AI-værktøjer direkte i deres platforme og udvider infrastrukturen i processen. Hyperscalers som AWS, Google Cloud og Azure etablerer regionale tilgængelighedszoner for at betjene lokale AI-arbejdsbelastninger. De tilbyder forudbyggede AI-pipelines, API’er og træningsmiljøer, der tiltrækker efterspørgsel fra virksomheder og udviklere. Nationale AI-strategier på tværs af APAC, herunder Indien, Kina og Singapore, fremskynder cloud-baseret AI-udvikling. Strategiske initiativer finansierer udvikling af datacentre, suveræn AI-infrastruktur og GPU-klyngeimplementering. Virksomheder foretrækker regionaliserede AI-træningsmiljøer for latenstid, datastyring og overholdelse. Det asiatiske og stillehavsområde AI-datacentermarkedet drager fordel af denne konvergens af cloud, AI og national politik. Det positionerer regionen som en foretrukken platform for AI-initiativer i virksomhedsskala.

- For eksempel inkluderer Indiens AIRAWAT-PSAI supercomputer 656 NVIDIA A100 GPU’er og understøtter 410 AI-petaflops af beregningskapacitet. Det fungerer som en national AI-forskningsinfrastruktur under Indiens AI- og supercomputing-missioner.

Vækst i branchespecifikke AI-applikationer på tværs af telekommunikation, sundhed og produktionsvertikaler

Telekommunikationsfirmaer implementerer AI for at optimere 5G-infrastruktur, netværksslicing og edge-behandling. Inden for sundhedsvæsenet bruger udbydere AI til at forbedre diagnostik, billedbehandling og automatisering af hospitalsarbejdsgange. Produktionsvirksomheder udnytter AI-drevne analyser til prædiktiv vedligeholdelse, fejldetektion og robotstyring. Denne sektorspecifikke adoption fører til vertikalspecifikke datacenterbyggerier. Operatører samlokaliserer nu AI-miljøer nær produktionscentre eller forskningscampusser. AI-træningscyklusser kræver lavere latenstid, edge-inferenskapacitet og høj-gennemstrømnings-backhaul. Nye arbejdsbelastninger inden for computer vision og realtidsanalyse presser traditionelle faciliteter. Det asiatiske og stillehavsområde AI-datacentermarkedet imødekommer disse vertikale behov med skræddersyet kapacitet og implementeringsmodeller. Det bliver en integreret del af digital transformation på tværs af store industrier.

Edge AI og mikrodatacenterimplementeringer transformerer infrastrukturforsyningsmodeller på tværs af byknudepunkter

Efterspørgslen efter lav-latens inferencing i detailhandel, mobilitet og IoT fører til distribuerede implementeringer. Edge AI-modeller kræver hurtig databehandling tæt på brugerens endepunkter. Lande som Japan, Sydkorea og Australien ser tidlig adoption af edge-klare mikrodatacentre. Detailkæder, autonome systemer og byinfrastruktur integrerer AI for smarte operationer. Disse tendenser flytter investeringer væk fra centraliseret træning alene mod decentraliseret udførelse. Nye formater inkluderer containeriserede AI-noder, modulære edge-enheder og smarte detailpods. De forbinder til centrale cloud-noder via fiber og 5G, hvilket danner hybride topologier. Det asiatiske stillehavsområde AI Datacenter-markedet drager fordel af denne edge-core integration, hvilket muliggør responsive, AI-native tjenester på tværs af byer. Det understøtter kritiske sektorer, der kræver øjeblikkelig, intelligent beslutningstagning.

Markeds Tendenser

Stigende Adoption af Væskekøling Muliggør 40–100 kW Rack Densiteter i AI Arbejdsbelastninger

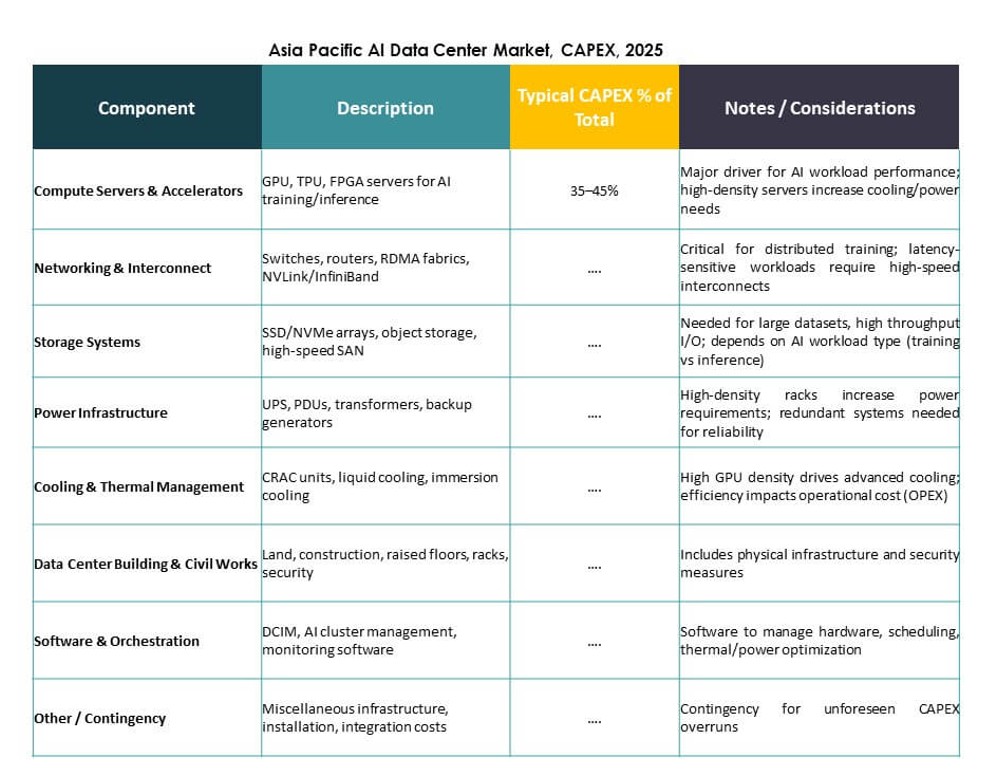

Luftbaserede kølesystemer står over for begrænsninger i håndteringen af stigende varmebelastninger fra GPU-baserede AI-servere. Væskekøling, især direkte-til-chip og bagdør varmevekslere, vinder frem. Operatører ombygger eller redesigner deres faciliteter for at understøtte 40–100 kW per rack. Dette skift muliggør tætte AI-klynger til træning af store fundamentmodeller. Datacentre i Singapore, Indien og Sydkorea er tidlige adoptører af væskekølede racks. Teknologileverandører tilbyder modulære systemer, der er kompatible med retrofit og greenfield byggerier. Implementeringen af nedsænkningskøling til HPC AI arbejdsbelastninger udvides også. Det asiatiske stillehavsområde AI Datacenter-markedet afspejler denne termiske overgang, da AI bliver mere beregningsintensiv. Det driver capex mod bæredygtige, høj-densitets operationer.

Integration af AI-Specifikke Interconnects og NVLink-Kompatibel Infrastruktur Forbedrer Beregningseffektivitet

Høj-båndbredde interconnects er kritiske for at forbinde GPU’er i AI-klynger. Faciliteter kræver nu topologier, der understøtter NVIDIA NVLink, PCIe Gen5 og Ethernet/Fabric forbedringer. Disse funktioner muliggør modeltræning på tværs af flere noder med minimal latens og høj gennemstrømning. Nye centre understøtter AI-supercomputere, storskala inferencing og multi-GPU optimering. Leverandører integrerer topologi-bevidste orkestreringsværktøjer for at reducere træningstid. Implementeringen af RDMA og smarte netværkslag forbedrer ydeevnen for distribuerede AI-job. Det asiatiske stillehavsområde AI Datacenter-markedet udvikler sig til at understøtte disse specifikationer for hyperscale og colocation kunder. Det forbedrer regional konkurrenceevne for globale AI-implementeringer.

Skift Mod AI-Optimerede Colocation Suiter Med Forudbestemte Beregnings- og Termiske Zoner

Colocation-udbydere udvikler dedikerede AI-zoner med forudgodkendt strøm, køling og rack-fodaftryk. Disse suiter henvender sig til kunder, der ønsker hurtig implementering uden redesign-cyklusser. Sådanne zoner inkluderer struktureret kabling, GPU-klare racks og forbedret luftbehandling eller væskekompatibilitet. Kunder drager fordel af reducerede provisioning-tider og forudsigelig AI-arbejdsbelastningsstøtte. Regioner som Hong Kong og Tokyo er førende inden for klar-til-implementering AI colocation. Mindre virksomheder bruger disse zoner til at teste og træne mindre LLM’er uden hyperscale capex. Det asiatiske stillehavsområde AI Datacenter-markedet afspejler denne modulering af colocation-tjenester skræddersyet til AI-kunder. Det understøtter hybride adoptionsmodeller i stor skala.

Fremkomsten af Suveræne AI-Zoner Understøttet af Nationale AI-Cloud og Forskningsrammer

Regeringer finansierer datacentre med sikker infrastruktur til udvikling af AI-modeller under suveræne rammer. Disse zoner understøtter nationale sprogmodeller, industrielle AI-initiativer og reguleret datatræning. Infrastrukturpartnere implementerer sikrede GPU-klynger med begrænset adgang og reviderede AI-pipelines. Eksempler inkluderer Indiens Bhashini-initiativ og Kinas provinsielle AI-zoner. Disse udviklinger skaber lokaliseret efterspørgsel efter AI-native beregninger inden for nationale grænser. Operatører arbejder med offentlige institutioner for at tilpasse infrastrukturen til politiske mål. Det asiatiske stillehavsområde AI Data Center Market inkorporerer dette samarbejde mellem regering og industri i sin struktur. Det positionerer regionen som en leder inden for suveræn AI-parathed.

Markedsudfordringer

Strømbegrænsninger, jordmangel og miljøpres i tætte urbane AI-klynger

Strømtilgængelighed er blevet en flaskehals i byer som Tokyo, Singapore og Seoul. AI-datacentre kræver høje og stabile strømbelastninger, men bynetværk står over for konkurrerende krav. Jordmangel og strenge zoneinddelinger gør nye byggerier vanskelige. Tilladelsesforsinkelser hindrer ofte hyperskala byggetidslinjer. Operatører skal navigere i udviklende energiregler og kulstofmål. Flydende kølesystemer kræver også betydelige vandressourcer i nogle designs. Bæredygtighedskrav skaber spændinger mellem tæthedsmål og ressourcebegrænsninger. Det asiatiske stillehavsområde AI Data Center Market skal løse disse udfordringer for at opretholde sin vækstmomentum. Det kræver langsigtet koordinering med forsynings-, kommunale og regulerende organer.

Begrænset adgang til AI-kompatibel hardware og talent forsinker implementeringstidslinjer på tværs af udviklingsøkonomier

Forsyningskædehuller begrænser rettidig adgang til avancerede GPU’er som NVIDIA H100 eller AMD MI300. Mindre lande i Sydøstasien og Sydasien kæmper for at sikre disse komponenter. Leveringstider forlænger implementeringen og begrænser innovation uden for større knudepunkter. Ligeledes forsinker mangel på uddannede ingeniører og AI-infrastrukturarkitekter projektberedskab. Nye markeder står over for mangel på færdigheder inden for orkestrering, overvågning og arbejdsbyrdeoptimering. Cloud-udbydere tilbyder administrerede AI-tjenester, men disse er stadig afhængige af tilgængeligheden af kerneinfrastruktur. Det asiatiske stillehavsområde AI Data Center Market oplever ujævn vækst, hvor talent- og hardwareadgang forbliver lav. At adressere dette kræver regional træning og strategiske leverandørpartnerskaber.

Markedsmuligheder

Udvidelse af virksomheders AI på tværs af mellemstore virksomheder driver efterspørgsel efter colocation og hybrid implementering

Virksomheder inden for fremstilling, logistik og detailhandel udvider interne AI-teams. Disse virksomheder kræver skalerbare, men omkostningseffektive beregningsmiljøer. AI-klar colocation giver fleksibilitet med høj ydeevne og lave kapitalomkostninger. Regionale operatører samler GPU-hardware, orkestrering og overholdelsesfunktioner. Dette åbner for vækst i byer ud over Tier-1 knudepunkter. Det asiatiske stillehavsområde AI Data Center Market understøtter disse behov gennem modulær kapacitet og hybride servicemodeller. Det er i overensstemmelse med SMV-digitalisering og sektorspecifik innovation.

Offentlige investeringer i AI-forskningsinfrastruktur skaber langsigtet regional efterspørgsel

Nationale regeringer finansierer AI-centre knyttet til uddannelse, forsvar og folkesundhed. Disse centre kræver stabile GPU-klynger og lokaliseret beregning. Infrastrukturpartnerskaber sikrer ydeevne, sikkerhed og overholdelse af datalokalitet. Operatører tilpasser tilbud til offentlige forskningsmål. Asien-Stillehavsområdets AI-datacentermarked drager fordel af denne konsistente investeringscyklus. Det opretholder efterspørgsel på tværs af politiske og finansielle tidslinjer.

Markedssegmentering

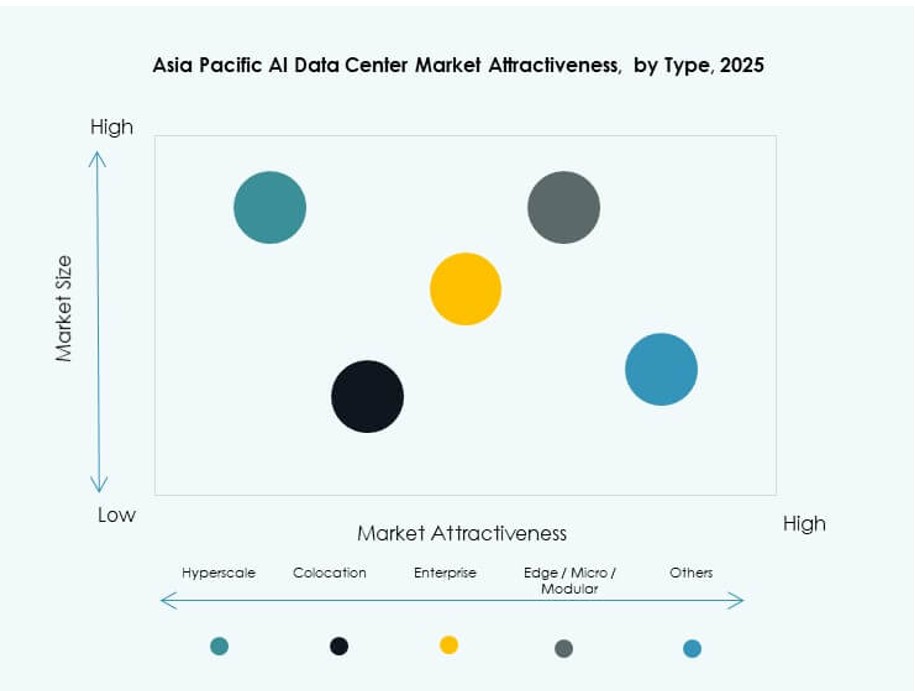

Efter type

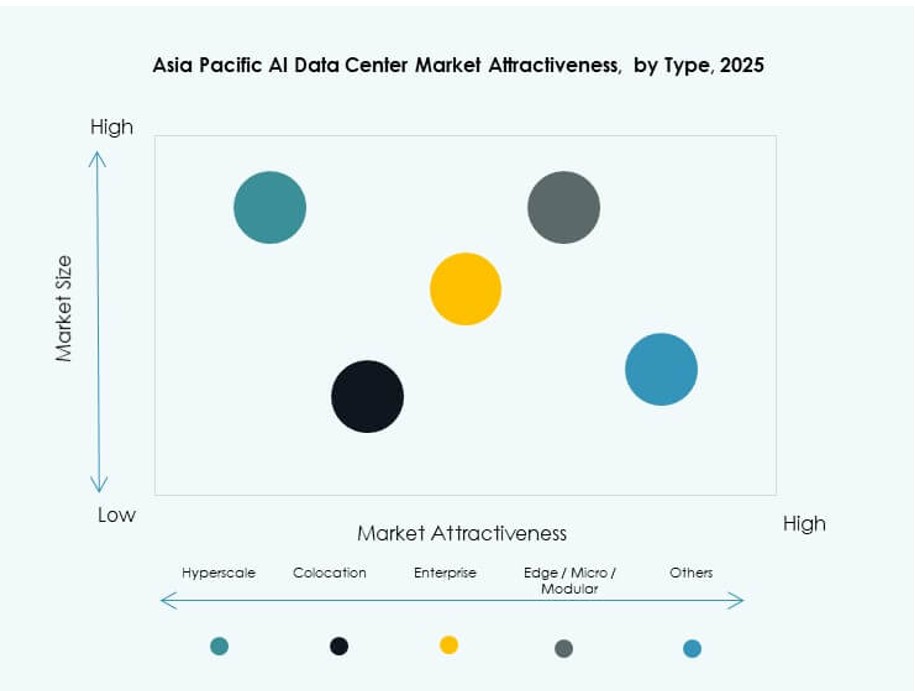

Hyperscale-datacentre dominerer Asien-Stillehavsområdets AI-datacentermarked med betydelig andel på grund af store investeringer fra globale cloud- og AI-virksomheder. Disse faciliteter tilbyder massiv skala, høj GPU-tæthed og integration med AI-acceleratorer. Colocation og virksomhedsudrulninger forbliver stærke i storbyer med regulerede AI-miljøer. Edge- og mikrodatasentre vokser i Sydøstasien for at imødekomme lav-latenskrav til detailhandel, mobilitet og smarte byapplikationer.

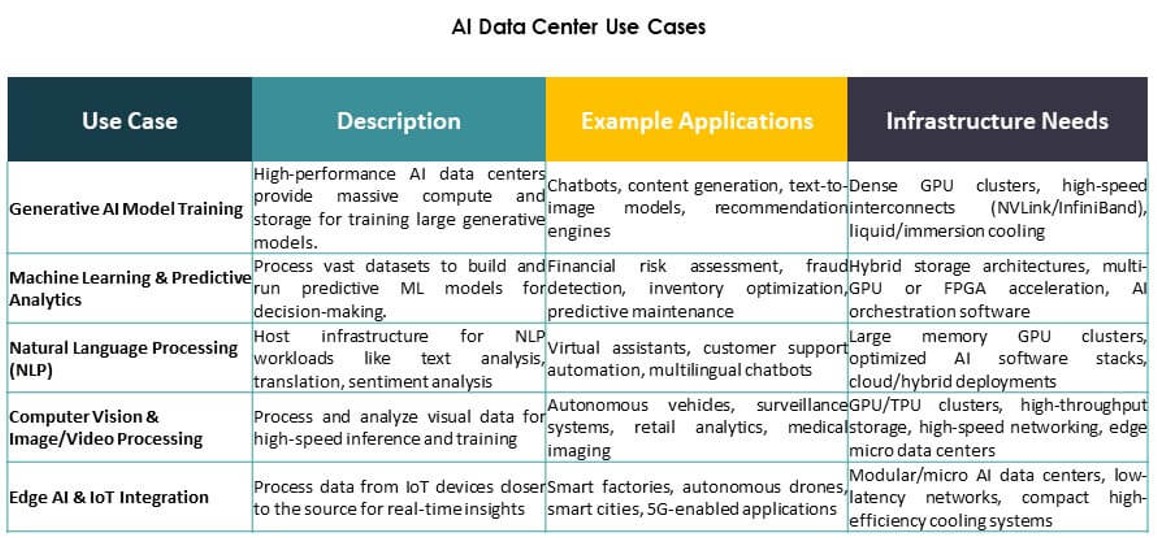

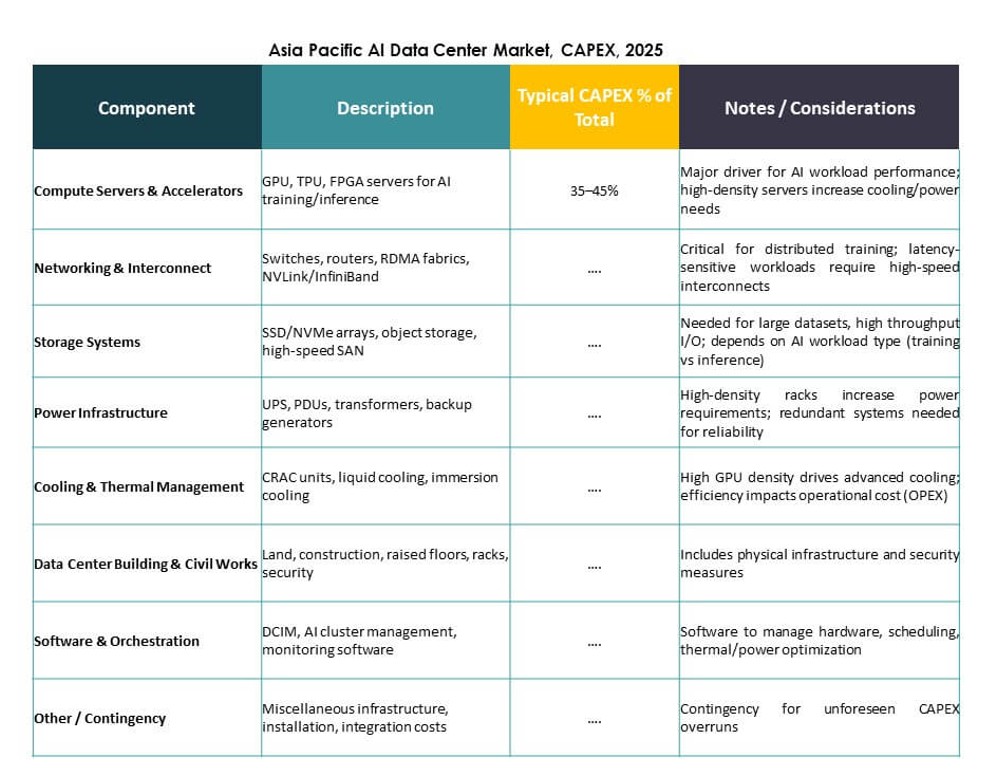

Efter komponent

Hardware repræsenterer den største andel på grund af omfattende GPU-, CPU- og lagerkrav til AI-arbejdsbelastninger. Store investeringer målretter høj-båndbredde interconnects, strømmoduler og termisk styring. Software og orkestrering vinder frem, da AI-træning kræver avanceret arbejdsbelastningsplanlægning, klyngeopskalering og containerstyring. Servicesegmentet vokser med efterspørgsel efter design, rådgivning og administrerede operationer i AI-specifikke miljøer.

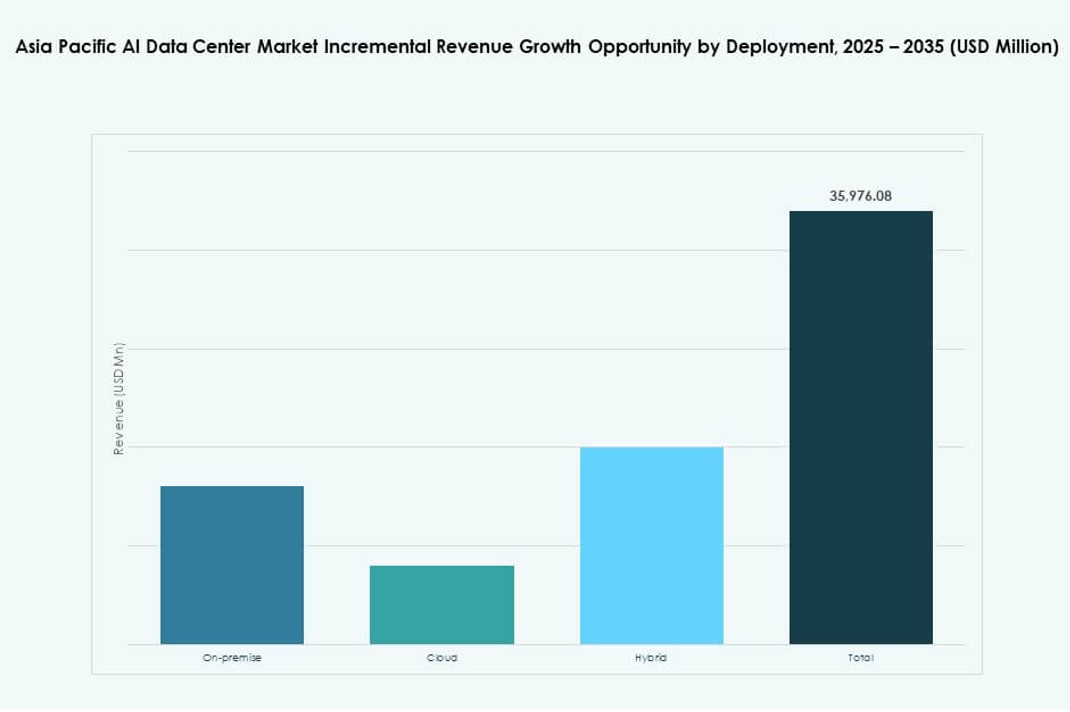

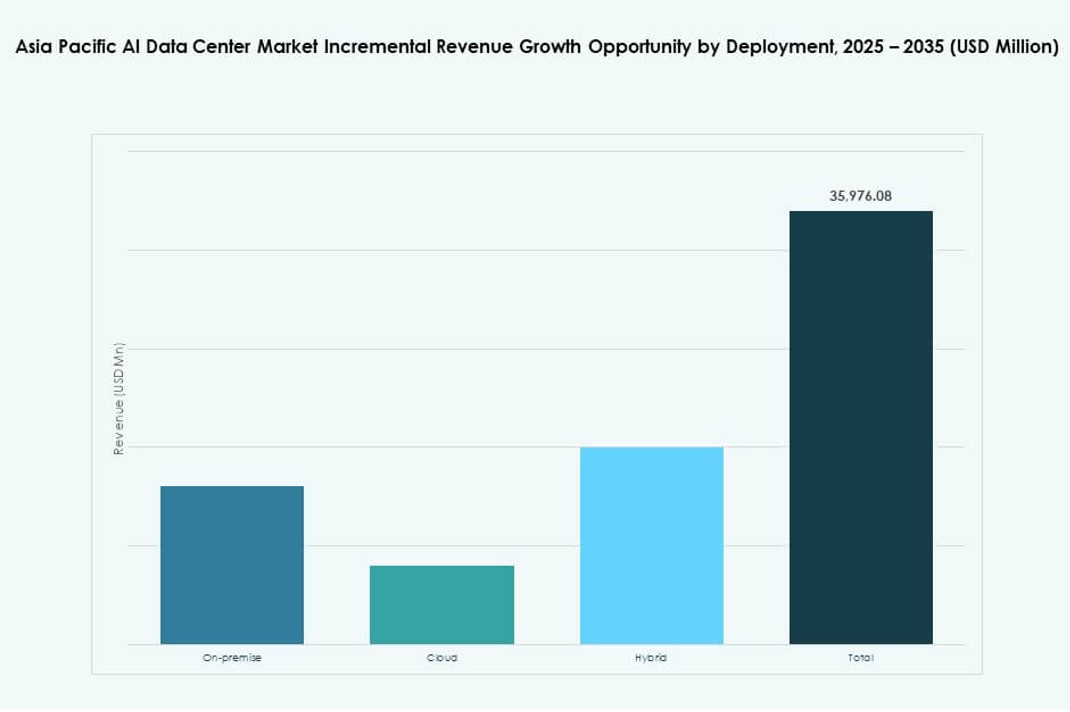

Efter implementering

Cloud-baseret AI-implementering fører markedet, drevet af hyperscaler-udvidelse og SMV’ers adoption af administreret AI-infrastruktur. On-premise forbliver relevant for regulerede industrier og AI-træning i kontrollerede miljøer. Hybridimplementeringsmodeller stiger, da virksomheder balancerer cloud-skalerbarhed med edge-baseret inferens og latensfølsomme anvendelser. Asien-Stillehavsområdets AI-datacentermarked tilpasser sig forskellige virksomheders modenhedsniveauer på tværs af underregioner.

Efter anvendelse

Maskinlæring har den største anvendelsesandel, især inden for virksomheds-AI og industriel analyse. Generativ AI er det hurtigst voksende segment, drevet af grundlæggende modeltræning og LLM-inferens. Computer Vision driver efterspørgsel inden for overvågning, detailhandel og industriel automatisering. NLP driver kontaktcentre, chatbots og oversættelsesværktøjer. Andre anvendelser inkluderer anbefalingsmotorer og tidsserieprognoser på tværs af BFSI og logistik.

Efter vertikal

IT og telekommunikation fører den vertikale segmentering, drevet af kerne-AI-infrastruktur og 5G-optimeringsanvendelser. BFSI og detailsektorer følger tæt, med fokus på bedrageridetektion, personalisering og chatbot-tjenester. Sundhedssektoren er i fremmarch med hurtig vækst inden for AI-diagnostik og hospitalsautomatisering. Efterspørgslen i bil- og fremstillingsindustrien vokser med AI-drevet produktion, robotteknologi og F&U. Asien-Stillehavsområdets AI-datacentermarked understøtter tværsektoriel transformation gennem vertikalt tilpasset infrastruktur.

Regionale indsigter

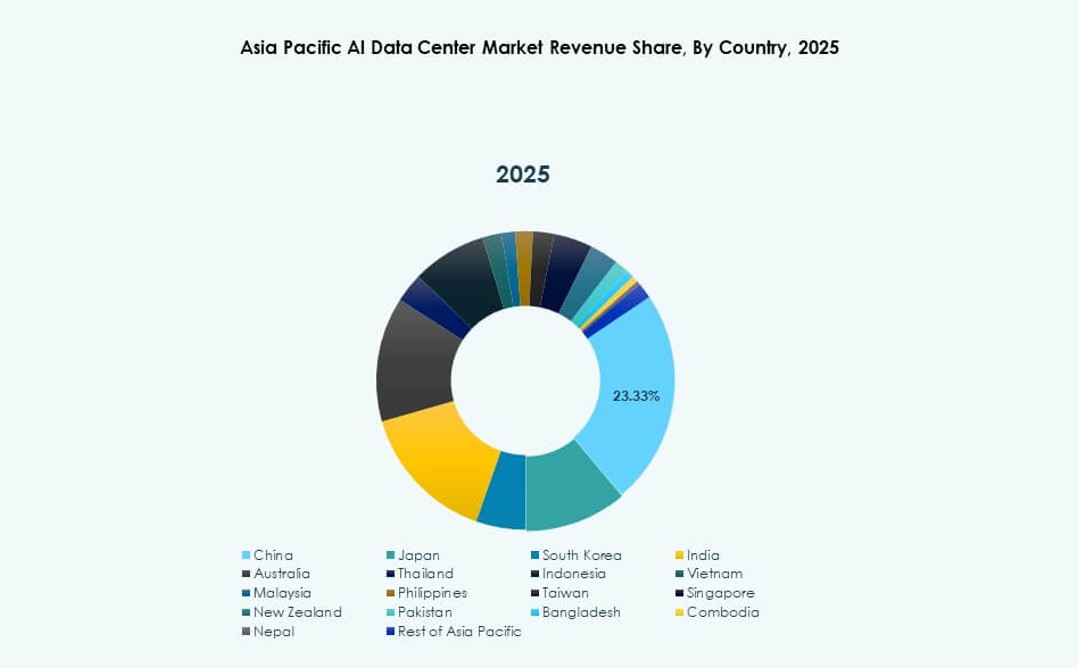

Østasien dominerer med over 42% markedsandel ledet af Kina, Japan og Sydkorea

Østasien har den største andel af det asiatiske stillehavsområde AI-datacenter marked med over 42%. Kina fører an med massive offentlige og private investeringer i AI-supercomputing knudepunkter. Japan og Sydkorea bidrager gennem robotteknologi, edge AI og national AI-politikudførelse. Disse lande drager fordel af tætte urbane teknologiklynger, stærk energiinfrastruktur og halvlederøkosystemer. Hyperscale og suveræne AI-implementeringer konvergerer her for at drive regionalt lederskab. Det forbliver AI-infrastrukturens anker i APAC.

- For eksempel opnåede Alibaba Cloud’s Tongyi Qianwen (Qwen-7B) model en score på 56,7 på MMLU-benchmarken på tværs af 57 opgaver i 2023.

Sydasien fremstår med over 26% andel drevet af Indiens cloud-udvidelse og talentbase

Sydasien tegner sig for over 26% af det asiatiske stillehavsområde AI-datacenter marked. Indien forankrer denne vækst med stærk udviklerbase, hyperscale cloud-zoner og nationale AI-rammer. Investeringer fra AWS, Microsoft og lokale virksomheder accelererer trænings- og inferenskapaciteter. Bangladesh og Pakistan er tidligt i udviklingen, men viser efterspørgsel fra fintech og sundhedssektoren. Sydasien vinder fremdrift gennem overkommelighed, dygtigt talent og stigende efterspørgsel fra virksomheder. Det udvikler sig til et regionalt AI-beregningscenter.

- For eksempel indgik Reliance Jio i september 2023 et partnerskab med NVIDIA for at opbygge AI-infrastruktur i Indien ved hjælp af NVIDIA GH200 Grace Hopper superchips og DGX Cloud-systemer. Samarbejdet understøtter storskala AI-arbejdsbelastninger gennem AI-klar datacentre drevet af Jio Platforms.

Sydøstasien og Oceanien fanger næsten 32% andel understøttet af strategisk placering og AI-parathed

Sydøstasien og Oceanien har tilsammen tæt på 32% markedsandel. Singapore, Indonesien og Australien fører infrastrukturudrulning gennem regionale AI-partnerskaber. Edge-implementeringer, 5G-integration og bæredygtig køleinnovation skiller sig ud. Thailand, Vietnam og Filippinerne ser stærke GenAI og edge AI anvendelsestilfælde i handel og uddannelse. Denne subregion balancerer global cloud-adgang og lokaliseret innovation. Det asiatiske stillehavsområde AI-datacenter marked drager fordel af sin centralitet og digitale økosystemstyrke.

Konkurrenceindsigt:

- ST Telemedia Data Centres

- Princeton Digital Group

- AirTrunk

- Microsoft (Azure)

- Amazon Web Services (AWS)

- Google Cloud

- Meta Platforms

- NVIDIA

- Dell Technologies

- Equinix

Det asiatiske stillehavsområde AI-datacenter marked er meget konkurrencepræget, formet af hyperscalers, regionale colocation-udbydere og globale hardwareleverandører. Operatører som ST Telemedia, Princeton Digital og AirTrunk fører an i facilitetudrulning på tværs af højvækstlande. Cloud-giganter inklusive Microsoft, AWS og Google fortsætter med at udvide AI-træningszoner på tværs af by- og edge-noder. Meta og NVIDIA øger efterspørgslen gennem skalering af grundlæggende modeller og hardwareintegration. Hardwareledere som Dell og Equinix muliggør infrastruktur fleksibilitet, der tilpasser sig udviklende AI-arbejdsbelastninger. Virksomheder konkurrerer på køleinnovation, energieffektivitet og AI-specifik beregningstæthed. Det forbliver dynamisk, med stærk regional ekspansion, økosystempartnerskaber og suveræn AI-zone tilpasning, der driver vedvarende konkurrence.

Seneste udviklinger:

- I oktober 2025 indgik AirTrunk et strategisk partnerskab med Humain og Blackstone for at udvikle næste generations AI-datacentre i Saudi-Arabien, startende med en campusinvestering på $3 milliarder rettet mod hyperscale og AI-infrastruktur

- I oktober 2025 blev Aligned Data Centers opkøbt af BlackRock og MGX i en rekordstor aftale på $40 milliarder, der rangerer blandt de største infrastrukturkøb nogensinde. Transaktionen vil udvide Aligned’s tilstedeværelse og fremskynde udrulningen af hyperscale og AI-optimerede datacentre globalt.

- I april 2025 lancerede ST Telemedia Global Data Centres en AI-klar datacenter-campus i Kolkata, Indien, med en investering på INR 450 crore for at understøtte voksende AI-arbejdsmængder i Asien og Stillehavsområdet.