Zusammenfassung:

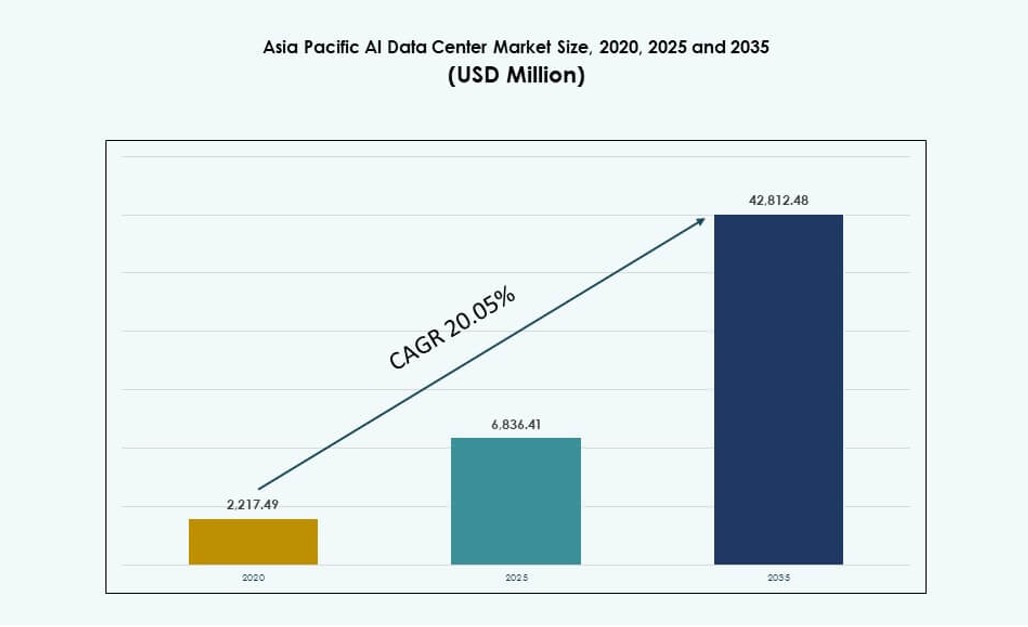

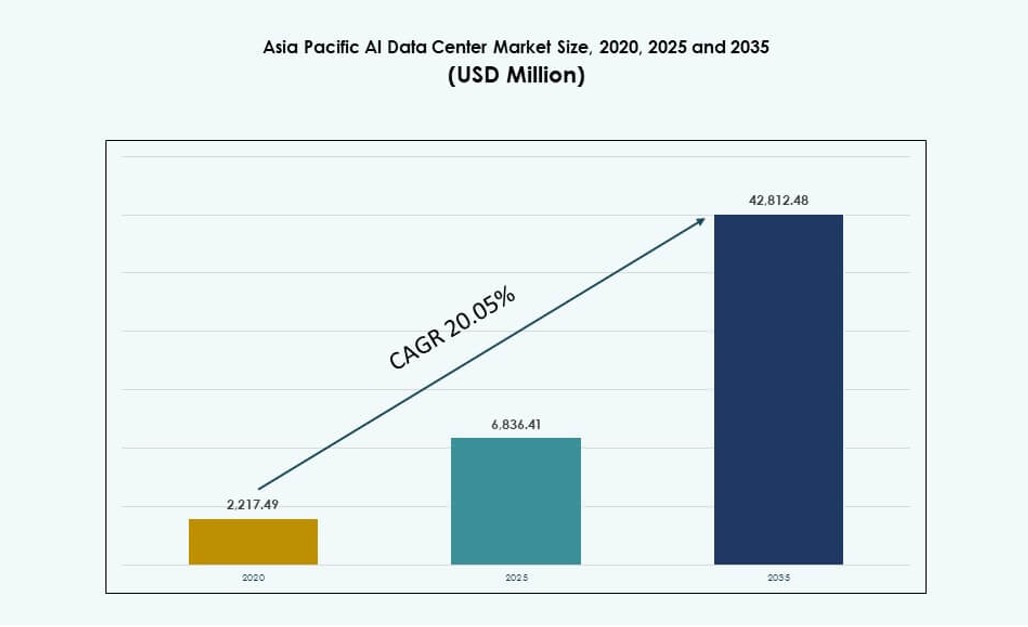

Der Markt für KI-Rechenzentren im asiatisch-pazifischen Raum wurde 2020 mit 2.217,49 Millionen USD bewertet und soll bis 2025 auf 6.836,41 Millionen USD und bis 2035 auf 42.812,48 Millionen USD anwachsen, mit einer jährlichen Wachstumsrate (CAGR) von 20,05 % im Prognosezeitraum.

| BERICHTSATTRIBUT |

DETAILS |

| Historischer Zeitraum |

2020-2023 |

| Basisjahr |

2024 |

| Prognosezeitraum |

2025-2035 |

| Marktgröße für KI-Rechenzentren im asiatisch-pazifischen Raum 2025 |

USD 6.836,41 Millionen |

| Markt für KI-Rechenzentren im asiatisch-pazifischen Raum, CAGR |

20,05% |

| Marktgröße für KI-Rechenzentren im asiatisch-pazifischen Raum 2035 |

USD 42.812,48 Millionen |

Der Markt entwickelt sich aufgrund der steigenden Nachfrage nach KI-spezifischer Infrastruktur, der weit verbreiteten Cloud-Expansion und der Einführung von Hochleistungs-GPU-Clustern. Unternehmen priorisieren Investitionen in speziell entwickelte Einrichtungen mit optimierter Kühlung, fortschrittlichen Verbindungen und KI-Orchestrierungsplattformen. Regierungen unterstützen nationale KI-Rahmenwerke mit souveränen Cloud-Politiken und Initiativen zur digitalen Wirtschaft. Innovationen im Bereich Edge-Computing und hybrider Architekturen verändern die Modelle der Infrastrukturbereitstellung. Hyperscale-Unternehmen und Colocation-Anbieter passen die Designs der Rechenzentren an, um den Anforderungen von KI-Training und -Inference gerecht zu werden. Die Region zieht Investoren an, die langfristige Renditen aus skalierbarer, nachhaltiger KI-Infrastruktur suchen.

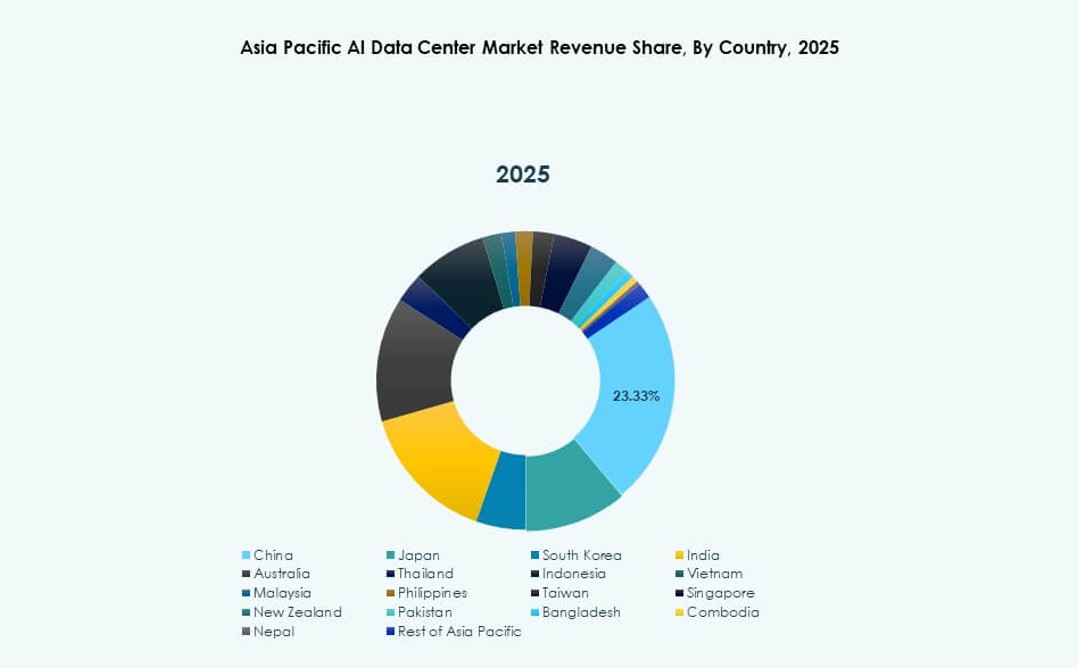

Ostasien dominiert die Landschaft, angeführt von China, Japan und Südkorea aufgrund starker Cloud-Durchdringung, nationaler KI-Strategien und dichter Technologiecluster. Südasien, insbesondere Indien, entwickelt sich schnell, angetrieben durch Hyperscale-Expansion und Verfügbarkeit von KI-Fähigkeiten. Südostasien und Ozeanien zeigen starke Dynamik, wobei Singapur, Indonesien und Australien in KI-Zonen und Edge-Deployments investieren. Die Region balanciert zentralisierte und verteilte Architekturen, um lokale Datenvorschriften und Latenzanforderungen zu erfüllen. Der Markt für KI-Rechenzentren im asiatisch-pazifischen Raum spiegelt eine dynamische Verschiebung hin zu lokalisierter KI-Kapazität wider, wobei regionale Wachstumsfaktoren die breitere digitale Transformation unterstützen.

Marktdynamik:

Markttreiber

Anstieg der KI-Workload-Anforderungen treibt Hochleistungs-GPU-Infrastruktur und Neubauten von Einrichtungen an

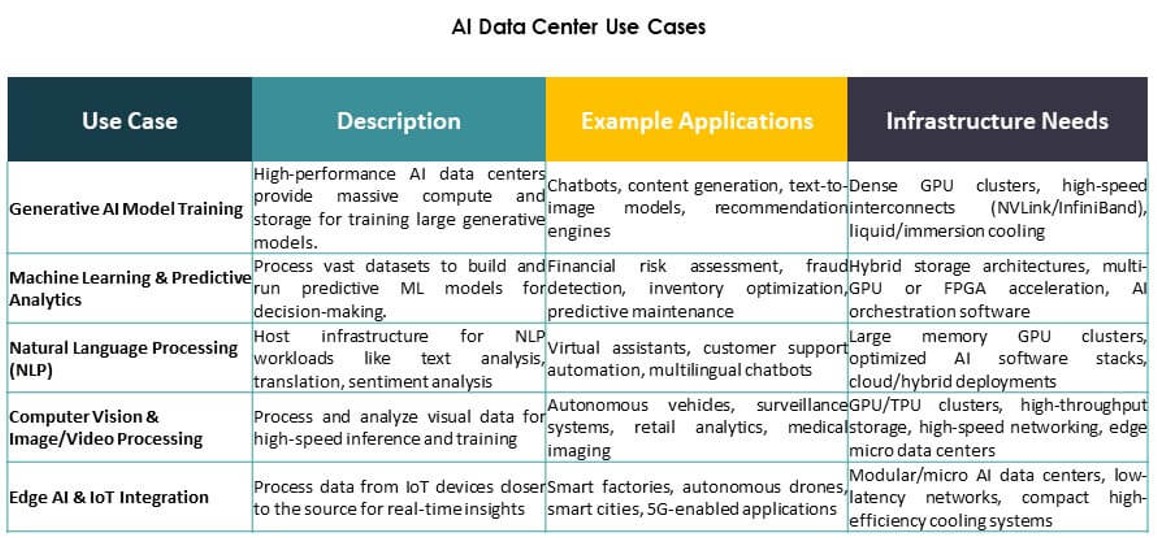

Der Markt für KI-Datenzentren im asiatisch-pazifischen Raum expandiert schnell aufgrund der steigenden Nachfrage nach Hochleistungsrechnern. KI-Modelle erfordern nun dichte GPU-Cluster und schnelle Verbindungen, was die Datenzentren dazu zwingt, bestehende Infrastrukturen neu zu gestalten. Unternehmen wechseln von traditionellen CPU-zentrierten Servern zu GPU- und KI-beschleunigter Hardware. Dieser Hardwarewechsel erhöht den Bedarf an Kühlungseffizienz, Energieoptimierung und Rack-Level-Dichteplanung. Betreiber investieren in nächste Generationen von KI-Trainings- und Inferenzumgebungen. Hyperscale- und Cloud-native Plattformen priorisieren die Verfügbarkeit von KI-Rechenleistung in regionalen Hubs. Die strategische Bedeutung steigt, da APAC zum zentralen Punkt für die Skalierbarkeit von KI-Einsätzen wird. Es dient sowohl globalen Akteuren als auch lokalen KI-Startups, die Leistung, Skalierung und Reichweite suchen.

- zum Beispiel liefern NVIDIA H100 Tensor Core GPUs 3.958 TeraFLOPS FP8 Tensor Core Leistung pro GPU.

Erhöhte Cloud-KI-Adoption und Plattformintegration durch Technologieriesen und staatliche KI-Missionen

Cloud-Dienstleister integrieren KI-Tools direkt in ihre Plattformen und erweitern dabei die Infrastruktur. Hyperscaler wie AWS, Google Cloud und Azure richten regionale Verfügbarkeitszonen ein, um lokale KI-Workloads zu bedienen. Sie bieten vorgefertigte KI-Pipelines, APIs und Trainingsumgebungen, die die Nachfrage von Unternehmen und Entwicklern anziehen. Nationale KI-Strategien im asiatisch-pazifischen Raum, einschließlich Indien, China und Singapur, beschleunigen die cloudbasierte KI-Entwicklung. Strategische Initiativen finanzieren den Ausbau von Datenzentren, souveräne KI-Infrastrukturen und den Einsatz von GPU-Clustern. Unternehmen bevorzugen regionalisierte KI-Trainingsumgebungen aufgrund von Latenz, Datenverwaltung und Compliance. Der Markt für KI-Datenzentren im asiatisch-pazifischen Raum profitiert von dieser Konvergenz von Cloud, KI und nationaler Politik. Er positioniert die Region als bevorzugte Startrampe für KI-Initiativen im Unternehmensmaßstab.

- Zum Beispiel umfasst Indiens AIRAWAT-PSAI-Supercomputer 656 NVIDIA A100 GPUs und unterstützt 410 KI-Petaflops Rechenkapazität. Er dient als nationale KI-Forschungsinfrastruktur im Rahmen von Indiens KI- und Supercomputing-Missionen.

Wachstum in branchenspezifischen KI-Anwendungen in den Bereichen Telekommunikation, Gesundheitswesen und Fertigung

Telekommunikationsunternehmen setzen KI ein, um 5G-Infrastrukturen, Netzwerkslicing und Edge-Processing zu optimieren. Im Gesundheitswesen nutzen Anbieter KI zur Verbesserung der Diagnostik, Bildgebung und Automatisierung von Krankenhausabläufen. Fertigungsunternehmen nutzen KI-gesteuerte Analysen für prädiktive Wartung, Fehlererkennung und Robotiksteuerung. Diese sektorale Adoption führt zu branchenspezifischen Datenzentrumsbauten. Betreiber verlagern nun KI-Umgebungen in die Nähe von Produktionszentren oder Forschungscampus. KI-Trainingszyklen erfordern geringere Latenz, Edge-Inferenzfähigkeit und hochdurchsatzfähige Backhaul. Neue Workloads in der Computer Vision und Echtzeitanalytik setzen traditionelle Einrichtungen unter Druck. Der Markt für KI-Datenzentren im asiatisch-pazifischen Raum adressiert diese vertikalen Bedürfnisse mit maßgeschneiderter Kapazität und Bereitstellungsmodellen. Er wird integraler Bestandteil der digitalen Transformation in großen Industrien.

Edge-KI- und Mikro-Datenzentrumsbereitstellungen transformieren Infrastrukturliefermodelle in urbanen Zentren

Die Nachfrage nach Inferencing mit niedriger Latenz in den Bereichen Einzelhandel, Mobilität und IoT führt zu verteilten Bereitstellungen. Edge-AI-Modelle erfordern eine schnelle Datenverarbeitung in der Nähe von Benutzerendpunkten. Länder wie Japan, Südkorea und Australien erleben eine frühe Einführung von edge-fähigen Mikro-Rechenzentren. Einzelhandelsketten, autonome Systeme und städtische Infrastrukturen integrieren KI für intelligente Betriebsabläufe. Diese Trends verlagern Investitionen weg von rein zentralisiertem Training hin zu dezentraler Ausführung. Neue Formate umfassen containerisierte KI-Knoten, modulare Edge-Einheiten und intelligente Einzelhandelspods. Sie verbinden sich über Glasfaser und 5G mit zentralen Cloud-Knoten und bilden hybride Topologien. Der asiatisch-pazifische KI-Datenzentrum-Markt profitiert von dieser Edge-Core-Integration, die reaktionsschnelle, KI-native Dienste in Städten ermöglicht. Es unterstützt kritische Sektoren, die sofortige, intelligente Entscheidungsfindung erfordern.

Markttrends

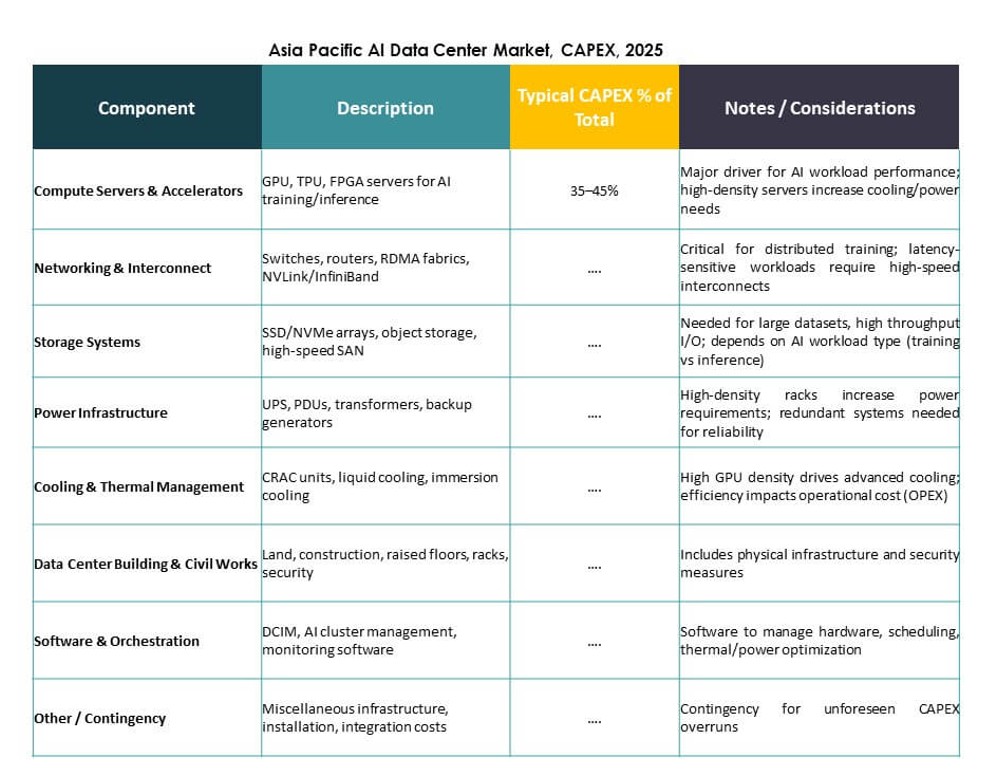

Steigende Einführung von Flüssigkeitskühlung zur Ermöglichung von 40–100 kW Rack-Dichten bei KI-Workloads

Luftbasierte Kühlsysteme stoßen an ihre Grenzen bei der Bewältigung steigender Wärmebelastungen durch GPU-basierte KI-Server. Flüssigkeitskühlung, insbesondere Direct-to-Chip und Rücktür-Wärmetauscher, gewinnt an Bedeutung. Betreiber rüsten ihre Einrichtungen um oder gestalten sie neu, um 40–100 kW pro Rack zu unterstützen. Dieser Wandel ermöglicht dichte KI-Cluster für das Training großer Grundmodelle. Rechenzentren in Singapur, Indien und Südkorea sind frühe Anwender flüssigkeitsgekühlter Racks. Technologielieferanten bieten modulare Systeme an, die mit Retrofit- und Greenfield-Bauten kompatibel sind. Der Einsatz von Immersionskühlung für HPC-KI-Workloads nimmt ebenfalls zu. Der asiatisch-pazifische KI-Datenzentrum-Markt spiegelt diesen thermischen Übergang wider, da KI immer rechenintensiver wird. Es treibt Investitionen in nachhaltige, hochdichte Betriebsabläufe voran.

Integration von KI-spezifischen Interconnects und NVLink-kompatibler Infrastruktur zur Verbesserung der Recheneffizienz

Hochbandbreiten-Interconnects sind entscheidend für die Verbindung von GPUs in KI-Clustern. Einrichtungen benötigen jetzt Topologien, die NVIDIA NVLink, PCIe Gen5 und Ethernet/Fabric-Verbesserungen unterstützen. Diese Funktionen ermöglichen das Modelltraining über mehrere Knoten mit minimaler Latenz und hoher Durchsatzrate. Aufstrebende Zentren unterstützen KI-Supercomputer, groß angelegte Inferenz und Multi-GPU-Optimierung. Anbieter integrieren topologiebewusste Orchestrierungswerkzeuge, um die Trainingszeit zu verkürzen. Der Einsatz von RDMA und intelligenten Netzwerkschichten verbessert die Leistung für verteilte KI-Aufgaben. Der asiatisch-pazifische KI-Datenzentrum-Markt entwickelt sich, um diese Spezifikationen für Hyperscale- und Colocation-Kunden zu unterstützen. Es verbessert die regionale Wettbewerbsfähigkeit für globale KI-Bereitstellungen.

Verlagerung hin zu KI-optimierten Colocation-Suiten mit vorab bereitgestellten Rechen- und Thermozonen

Colocation-Anbieter entwickeln dedizierte KI-Zonen mit vorab genehmigter Stromversorgung, Kühlung und Rack-Fußabdrücken. Diese Suiten richten sich an Kunden, die eine schnelle Bereitstellung ohne Neugestaltungszyklen wünschen. Solche Zonen umfassen strukturierte Verkabelung, GPU-fähige Racks und verbesserte Luftbehandlung oder Flüssigkeitskompatibilität. Kunden profitieren von verkürzten Bereitstellungszeiten und vorhersehbarer Unterstützung von KI-Workloads. Regionen wie Hongkong und Tokio führen in der Bereitstellung von einsatzbereiten KI-Colocation. Kleinere Unternehmen nutzen diese Zonen, um kleinere LLMs zu testen und zu trainieren, ohne Hyperscale-Investitionen. Der asiatisch-pazifische KI-Datenzentrum-Markt spiegelt diese Modularisierung von Colocation-Diensten wider, die auf KI-Kunden zugeschnitten sind. Es unterstützt hybride Adoptionsmodelle im großen Maßstab.

Entstehung souveräner KI-Zonen unterstützt durch nationale KI-Cloud- und Forschungsrahmenwerke

Regierungen finanzieren Rechenzentren mit sicherer Infrastruktur für die Entwicklung von KI-Modellen unter souveränen Rahmenbedingungen. Diese Zonen unterstützen nationale Sprachmodelle, industrielle KI-Initiativen und reguliertes Datentraining. Infrastrukturpartner setzen gesicherte GPU-Cluster mit eingeschränktem Zugang und geprüften KI-Pipelines ein. Beispiele hierfür sind Indiens Bhashini-Initiative und Chinas provinzielle KI-Zonen. Diese Entwicklungen schaffen eine lokale Nachfrage nach KI-nativer Rechenleistung innerhalb nationaler Grenzen. Betreiber arbeiten mit öffentlichen Institutionen zusammen, um die Infrastruktur mit politischen Zielen in Einklang zu bringen. Der Asia Pacific AI Data Center Market integriert diese Zusammenarbeit zwischen Regierung und Industrie in seine Struktur. Er positioniert die Region als führend in der Bereitschaft für souveräne KI.

Marktherausforderungen

Leistungsbeschränkungen, Landknappheit und Umweltbelastungen in dichten urbanen KI-Clustern

Die Verfügbarkeit von Strom ist in Städten wie Tokio, Singapur und Seoul zu einem Engpass geworden. KI-Rechenzentren erfordern hohe und stabile Stromlasten, aber städtische Netze stehen vor konkurrierenden Anforderungen. Landknappheit und strenge Zoneneinteilungen erschweren Neubauten. Genehmigungsverzögerungen behindern oft die Bauzeitpläne im Hyperscale-Bereich. Betreiber müssen sich in sich entwickelnden Energieregulierungen und Kohlenstoffzielen zurechtfinden. Flüssigkeitskühlsysteme erfordern in einigen Designs auch erhebliche Wasserressourcen. Nachhaltigkeitsvorgaben schaffen Spannungen zwischen Dichtezielen und Ressourcenbeschränkungen. Der Asia Pacific AI Data Center Market muss diese Herausforderungen lösen, um sein Wachstumstempo beizubehalten. Es bedarf einer langfristigen Koordination mit Versorgungsunternehmen, kommunalen und regulatorischen Stellen.

Begrenzter Zugang zu KI-fähiger Hardware und Talent verzögert Bereitstellungszeitpläne in Entwicklungsländern

Lücken in der Lieferkette schränken den rechtzeitigen Zugang zu High-End-GPUs wie NVIDIA H100 oder AMD MI300 ein. Kleinere Länder in Südostasien und Südasien haben Schwierigkeiten, diese Komponenten zu sichern. Lange Vorlaufzeiten verlängern die Bereitstellung und begrenzen Innovationen außerhalb der großen Zentren. Ebenso verzögert der Mangel an ausgebildeten Ingenieuren und KI-Infrastrukturarchitekten die Projektbereitschaft. Schwellenmärkte stehen vor einem Mangel an Fähigkeiten in den Bereichen Orchestrierung, Überwachung und Workload-Optimierung. Cloud-Anbieter bieten verwaltete KI-Dienste an, aber diese sind immer noch auf die Verfügbarkeit der Kerninfrastruktur angewiesen. Der Asia Pacific AI Data Center Market erlebt ungleichmäßiges Wachstum, wo Talent- und Hardwarezugang gering bleiben. Dies erfordert regionale Schulungen und strategische Partnerschaften mit Anbietern.

Marktchancen

Expansion von Unternehmens-KI in mittelgroßen Unternehmen treibt die Nachfrage nach Colocation und hybriden Bereitstellungen an

Unternehmen in den Bereichen Fertigung, Logistik und Einzelhandel bauen interne KI-Teams aus. Diese Firmen benötigen skalierbare, aber kosteneffiziente Rechenumgebungen. KI-bereite Colocation bietet Flexibilität mit starker Leistung und niedrigen Kapitalkosten. Regionale Betreiber bündeln GPU-Hardware, Orchestrierung und Compliance-Funktionen. Dies eröffnet Wachstum in Städten jenseits der Tier-1-Zentren. Der Asia Pacific AI Data Center Market unterstützt diese Bedürfnisse durch modulare Kapazitäten und hybride Servicemodelle. Er stimmt mit der Digitalisierung von KMU und sektorspezifischen Innovationen überein.

Investitionen des öffentlichen Sektors in KI-Forschungsinfrastruktur schaffen langfristige regionale Nachfrage

Nationale Regierungen finanzieren KI-Zentren, die mit Bildung, Verteidigung und öffentlicher Gesundheit verbunden sind. Diese Zentren benötigen stabile GPU-Cluster und lokalisierte Rechenkapazitäten. Infrastrukturpartnerschaften gewährleisten Leistung, Sicherheit und Einhaltung der Datenresidenz. Betreiber stimmen ihre Angebote mit den Zielen der öffentlichen Forschung ab. Der Markt für KI-Datenzentren im asiatisch-pazifischen Raum profitiert von diesem konstanten Investitionszyklus. Er erhält die Nachfrage über politische und fiskalische Zeiträume hinweg aufrecht.

Marktsegmentierung

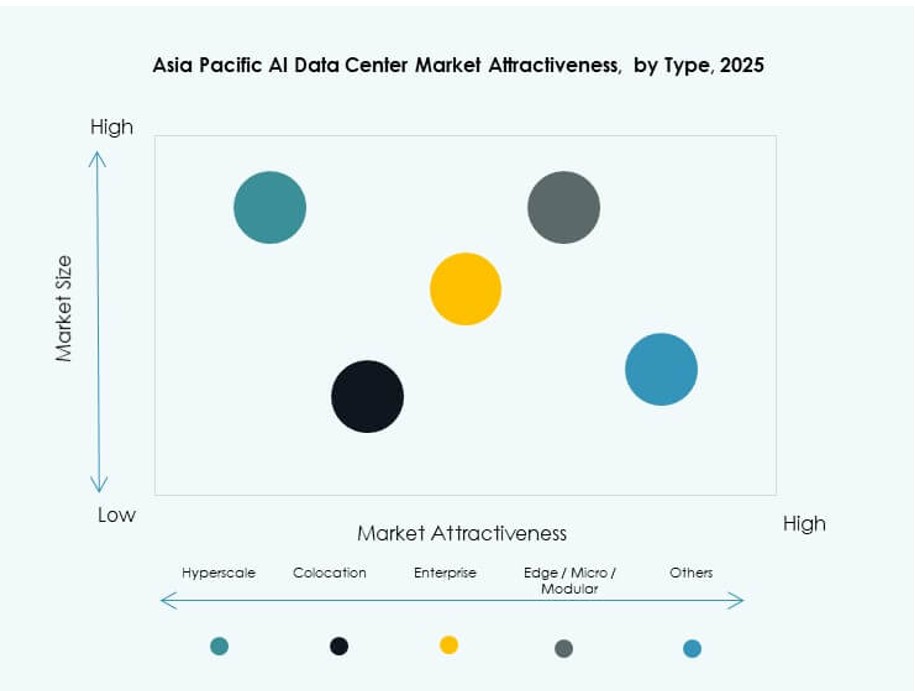

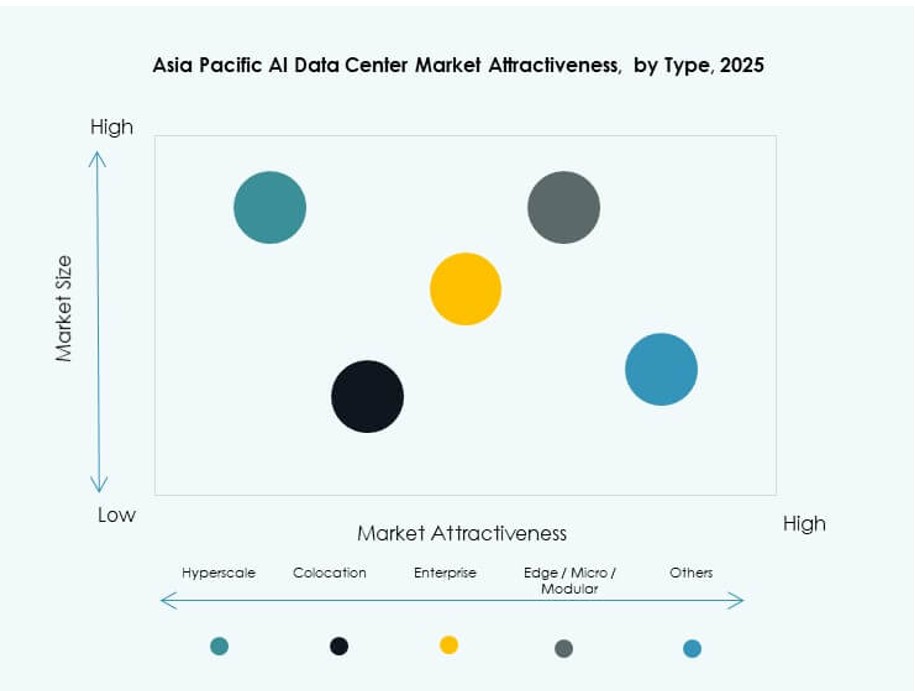

Nach Typ

Hyperscale-Datenzentren dominieren den Markt für KI-Datenzentren im asiatisch-pazifischen Raum mit einem bedeutenden Anteil aufgrund großer Investitionen globaler Cloud- und KI-Unternehmen. Diese Einrichtungen bieten massive Skalierung, hohe GPU-Dichte und Integration mit KI-Beschleunigern. Colocation und Unternehmensbereitstellungen bleiben in Metropolen mit regulierten KI-Umgebungen stark. Edge- und Mikro-Datenzentren wachsen in Südostasien, um den Anforderungen an niedrige Latenzzeiten für Einzelhandel, Mobilität und Smart-City-Anwendungen gerecht zu werden.

Nach Komponente

Hardware stellt den größten Anteil dar, aufgrund umfangreicher Anforderungen an GPUs, CPUs und Speicher für KI-Workloads. Große Investitionen zielen auf Hochgeschwindigkeitsverbindungen, Strommodule und Wärmemanagement ab. Software und Orchestrierung gewinnen an Bedeutung, da KI-Training fortschrittliche Workload-Planung, Cluster-Skalierung und Container-Management erfordert. Das Dienstleistungssegment wächst mit der Nachfrage nach Design, Beratung und Managed Operations in KI-spezifischen Umgebungen.

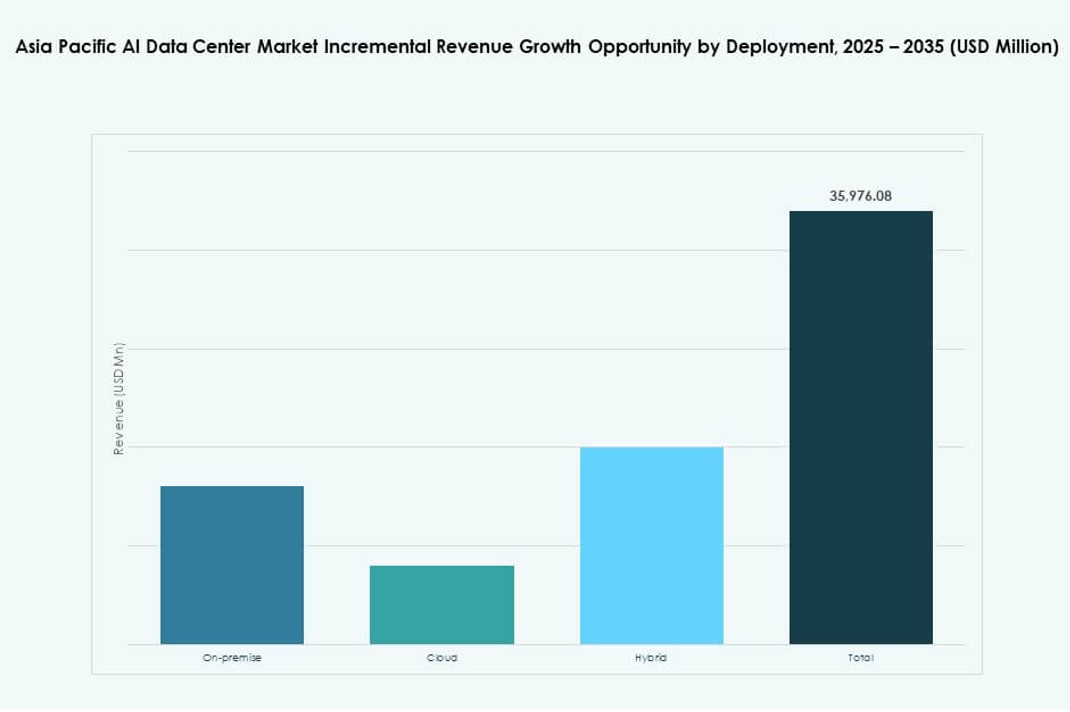

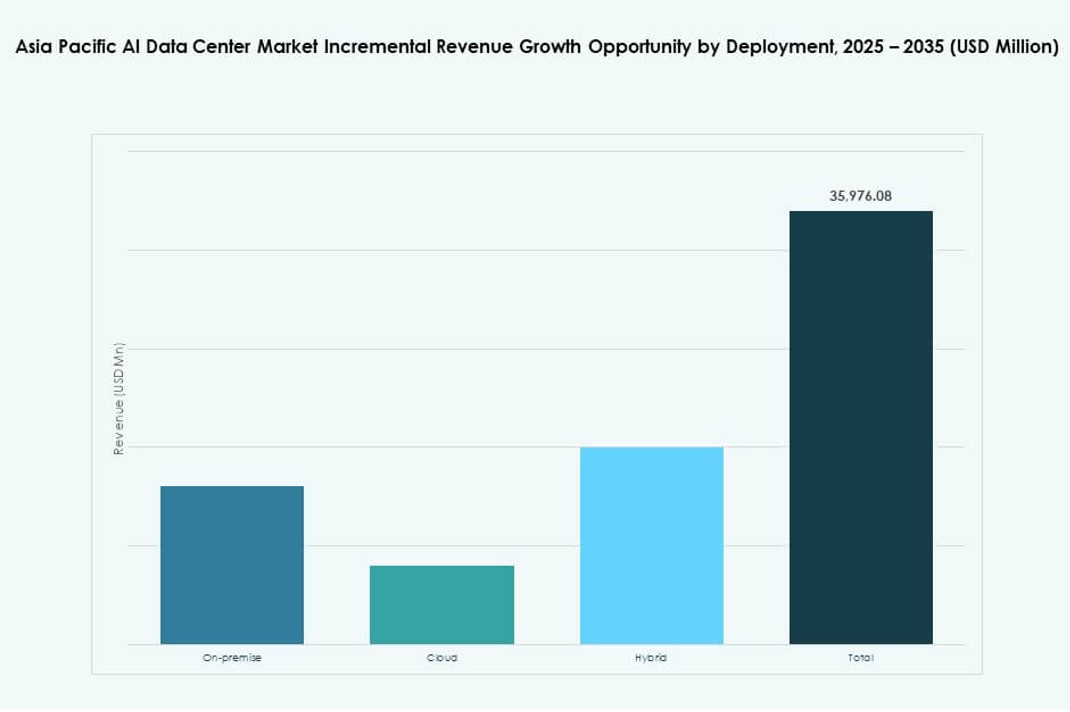

Nach Bereitstellung

Cloud-basierte KI-Bereitstellung führt den Markt an, angetrieben durch die Expansion von Hyperscalern und die Übernahme von Managed-AI-Infrastruktur durch KMU. On-Premise bleibt relevant für regulierte Branchen und KI-Training in kontrollierten Umgebungen. Hybride Bereitstellungsmodelle nehmen zu, da Unternehmen die Skalierbarkeit der Cloud mit Edge-basierter Inferenz und latenzsensitiven Anwendungsfällen ausbalancieren. Der Markt für KI-Datenzentren im asiatisch-pazifischen Raum stimmt mit unterschiedlichen Reifegraden von Unternehmen in den Teilregionen überein.

Nach Anwendung

Maschinelles Lernen hält den größten Anwendungsanteil, insbesondere in Unternehmens-KI und industrieller Analytik. Generative KI ist das am schnellsten wachsende Segment, angetrieben durch das Training von Foundation-Modellen und LLM-Inferenz. Computer Vision treibt die Nachfrage in Überwachung, Einzelhandel und industrieller Automatisierung an. NLP unterstützt Kontaktzentren, Chatbots und Übersetzungstools. Weitere Anwendungen umfassen Empfehlungssysteme und Zeitreihenprognosen in BFSI und Logistik.

Nach Branche

IT und Telekommunikation führen die vertikale Segmentierung an, angetrieben durch Kern-KI-Infrastruktur und 5G-Optimierungsanwendungsfälle. BFSI- und Einzelhandelssektoren folgen dicht, mit Fokus auf Betrugserkennung, Personalisierung und Chatbot-Dienste. Der Gesundheitssektor wächst schnell mit KI-Diagnostik und Krankenhausautomatisierung. Die Nachfrage in der Automobil- und Fertigungsindustrie wächst mit KI-gesteuerter Produktion, Robotik und F&E. Der Markt für KI-Datenzentren im asiatisch-pazifischen Raum unterstützt sektorübergreifende Transformationen durch vertikal ausgerichtete Infrastruktur.

Regionale Einblicke

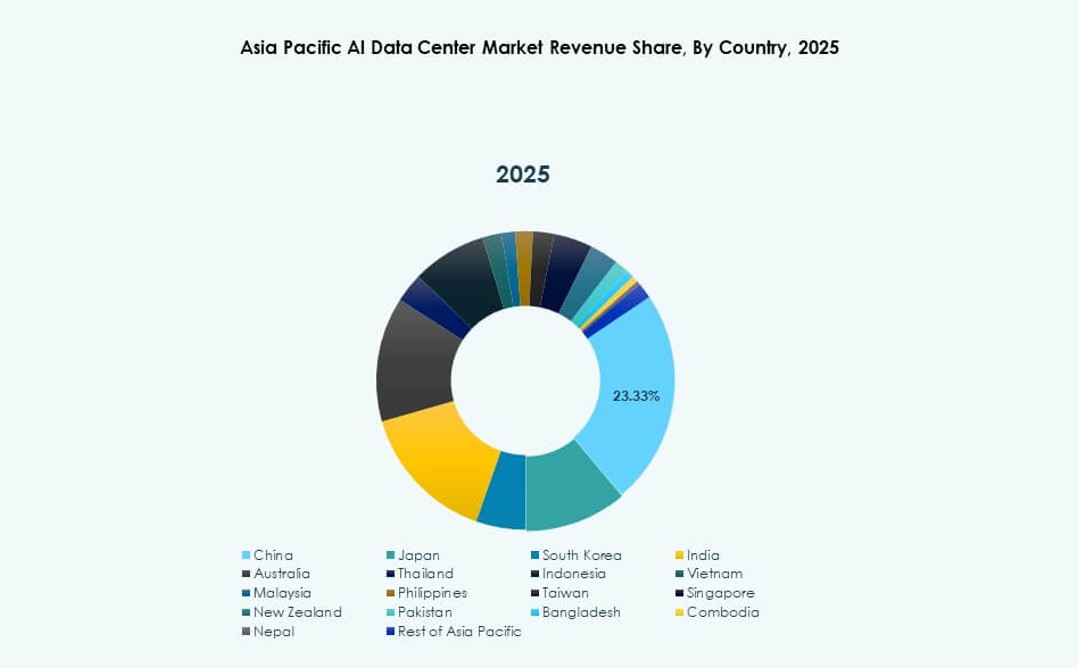

Ostasien dominiert mit über 42 % Marktanteil, angeführt von China, Japan und Südkorea

Ostasien hält mit über 42 % den größten Anteil am asiatisch-pazifischen Markt für KI-Datenzentren. China führt mit massiven öffentlichen und privaten Investitionen in KI-Supercomputing-Zentren. Japan und Südkorea tragen durch Robotik, Edge-KI und die Umsetzung nationaler KI-Politiken bei. Diese Länder profitieren von dichten urbanen Technologieclustern, einer starken Energieinfrastruktur und Halbleiterökosystemen. Hyperscale- und souveräne KI-Implementierungen konvergieren hier, um die regionale Führungsrolle voranzutreiben. Es bleibt der Anker der KI-Infrastruktur im APAC.

- Zum Beispiel erreichte das Tongyi Qianwen (Qwen-7B)-Modell von Alibaba Cloud im Jahr 2023 einen Wert von 56,7 im MMLU-Benchmark über 57 Aufgaben.

Südasien entwickelt sich mit über 26 % Anteil, angetrieben durch Indiens Cloud-Expansion und Talentbasis

Südasien macht über 26 % des asiatisch-pazifischen Marktes für KI-Datenzentren aus. Indien verankert dieses Wachstum mit einer starken Entwicklerbasis, Hyperscale-Cloud-Zonen und nationalen KI-Rahmenwerken. Investitionen von AWS, Microsoft und lokalen Unternehmen beschleunigen die Trainings- und Inferenzfähigkeiten. Bangladesch und Pakistan befinden sich noch in der Entwicklung, zeigen jedoch Nachfrage aus Fintech und Gesundheitswesen. Südasien gewinnt durch Erschwinglichkeit, qualifizierte Talente und steigende Unternehmensnachfrage an Bedeutung. Es entwickelt sich zu einem regionalen KI-Computing-Hub.

- Zum Beispiel ging Reliance Jio im September 2023 eine Partnerschaft mit NVIDIA ein, um KI-Infrastruktur in Indien mit NVIDIA GH200 Grace Hopper Superchips und DGX Cloud-Systemen aufzubauen. Die Zusammenarbeit unterstützt groß angelegte KI-Workloads durch KI-bereite Datenzentren, die von Jio Platforms betrieben werden.

Südostasien und Ozeanien erfassen fast 32 % Anteil, unterstützt durch strategische Lage und KI-Bereitschaft

Südostasien und Ozeanien halten zusammen fast 32 % Marktanteil. Singapur, Indonesien und Australien führen den Infrastrukturaufbau durch regionale KI-Partnerschaften an. Edge-Implementierungen, 5G-Integration und nachhaltige Kühlinnovationen stechen hervor. Thailand, Vietnam und die Philippinen verzeichnen starke GenAI- und Edge-KI-Anwendungsfälle im Handel und in der Bildung. Diese Subregion balanciert globalen Cloud-Zugang und lokale Innovation. Der asiatisch-pazifische Markt für KI-Datenzentren profitiert von seiner Zentralität und der Stärke des digitalen Ökosystems.

Wettbewerbseinblicke:

- ST Telemedia Data Centres

- Princeton Digital Group

- AirTrunk

- Microsoft (Azure)

- Amazon Web Services (AWS)

- Google Cloud

- Meta Platforms

- NVIDIA

- Dell Technologies

- Equinix

Der asiatisch-pazifische Markt für KI-Datenzentren ist hochgradig wettbewerbsfähig, geprägt von Hyperscalern, regionalen Colocation-Anbietern und globalen Hardware-Anbietern. Betreiber wie ST Telemedia, Princeton Digital und AirTrunk führen den Ausbau von Einrichtungen in wachstumsstarken Ländern an. Cloud-Giganten wie Microsoft, AWS und Google expandieren weiterhin in KI-Trainingszonen über städtische und Edge-Knoten hinweg. Meta und NVIDIA treiben die Nachfrage durch die Skalierung von Foundation-Modellen und Hardware-Integration voran. Hardware-Führer wie Dell und Equinix ermöglichen Infrastrukturflexibilität, die sich an die sich entwickelnden KI-Workloads anpasst. Unternehmen konkurrieren in den Bereichen Kühlinnovation, Energieeffizienz und KI-spezifische Rechendichte. Es bleibt dynamisch, mit starker regionaler Expansion, Ökosystempartnerschaften und der Ausrichtung auf souveräne KI-Zonen, die den anhaltenden Wettbewerb vorantreiben.

Neueste Entwicklungen:

- Im Oktober 2025 ging AirTrunk eine strategische Partnerschaft mit Humain und Blackstone ein, um Rechenzentren der nächsten Generation in Saudi-Arabien zu entwickeln, beginnend mit einer Investition von 3 Milliarden Dollar in einen Campus, der auf Hyperscale- und KI-Infrastruktur abzielt.

- Im Oktober 2025 wurde Aligned Data Centers von BlackRock und MGX in einem rekordverdächtigen 40-Milliarden-Dollar-Deal übernommen, der zu den größten Infrastrukturübernahmen aller Zeiten zählt. Die Transaktion wird Aligneds Präsenz erweitern und die Bereitstellung von hyperskaligen und KI-optimierten Rechenzentren weltweit beschleunigen.

- Im April 2025 eröffnete ST Telemedia Global Data Centres einen KI-fähigen Rechenzentrumscampus in Kolkata, Indien, mit einer Investition von 450 Crore INR, um das wachsende KI-Arbeitsaufkommen in der Asien-Pazifik-Region zu unterstützen.